Recomendaçãointegrar ferramentas aceleradas por IA para automatizar tarefas repetitivas, permitindo que profissionais dediquem grande parte de seu tempo à narrativa visual que ressoa com o público. definitivamente viável para equipes que tradicionalmente dependiam de polimento manual, mantendo o foco na qualidade essencial e cumprindo prazos apertados.

A IA remodela as tarefas dentro da pós-produção, movendo correção de cor rotineira, marcação de ativos e decisões de corte bruto para loops automatizados. Este artigo destaca como construir trilhas de auditoria transparentes e verificações com intervenção humana durante os testes piloto para garantir a sensibilidade ao tom e à nuance, apesar das restrições; isso minimiza o desvio entre cenas. Regular reuniões com ajuda de clientes e partes interessadas navegar expectativas e acelerar os ciclos do briefing à entrega.

Para profissionais que buscam aprimorar suas habilidades, quatro passos práticos: (1) criar uma biblioteca de predefinições assistidas por IA para cor, estabilização, geração de legendas e animação; (2) alinhar o crescimento de habilidades em torno de animação e design de som para suportar cortes automatizados; (3) definir essencial métricas para julgar a qualidade da saída além da velocidade; (4) executar reuniões com clientes para alinhar expectativas. Esta abordagem tradicionalmente fits business necessidades, preservando a intenção criativa.

Neste artigo, pilotos iniciantes demonstram ganhos: enorme reduções no tempo até o primeiro corte e aumento da consistência nos metadados. Na prática, o uso de IA para etiquetar e sugerir graus de edição pode reduzir em muito e melhorar a colaboração com audiências. A sensibilidade para arco narrativo é vital; os humanos devem revisar quadros críticos, especialmente em cenas de conflito. Ao planejar, pilote em um projeto representativo para medir o impacto e iterar.

Considerações para a adoção incluem o risco de derivação criativa, governança de dados, licenciamento para ativos gerados e alinhamento com os prazos dos clientes. Estabeleça uma propriedade clara para os resultados da IA e defina salvaguardas para cor, ritmo e design de som. Na prática, mantenha um time simplificado. produção pipeline e reuniões com as partes interessadas para calibrar o progresso; essa abordagem ajuda as equipes navegar expectations e entregar valor aos clientes, ao mesmo tempo que expande o alcance com o público.

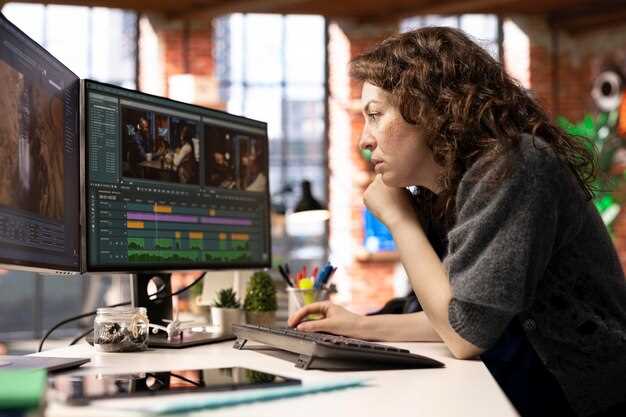

Mudanças Concretas nas Responsabilidades do Editor e Tarefas Diárias

Estabeleça um ciclo de edição modular que se baseie em predefinições de movimento e ativos de estoque para reduzir drasticamente as edições rotineiras, impulsionando os projetos em direção aos marcos de entrega com facilidade.

Crie uma biblioteca centralizada compartilhada por equipes colaboradoras, permitindo que milhares de clipes sejam selecionados com o mínimo de atrito, enquanto os videógrafos fornecem material no local.

Desmonte cronogramas tradicionais, combinando elementos de criação dinamicamente, permitindo que as opções de cores e as sequências de movimento sejam remontadas em segundos.

Mude a responsabilidade definindo etapas que exigem colaboração com os profissionais de marketing para garantir que o estoque e os recursos criados atendam aos objetivos da campanha.

Decisões de corte repetitivas descartadas dão lugar a escolhas informadas por dados; uma lista de pistas de análise orienta esta equipe para resultados mais rápidos e consistentes.

Showcases de projetos destacam como milhares de stakeholders percebem movimento, cores e ritmo; saber as emoções do público molda uma dança entre cortes, ajudando videógrafos e profissionais de marketing a convergirem para uma única visão.

a revolução avança, interrompe processos tradicionais, exigindo curadoria disciplinada e escuta do feedback dos colaboradores; esta realidade impulsiona milhares de criadores a se adaptar.

Registro automatizado e seleção de clipes: configurando predefinições e revisando as escolhas da IA

Configure presets para auto-registrar metadados essenciais para cada clip, incluindo tipo de tomada, localização, takes e duração; atribua uma pontuação de confiança às escolhas da IA e execute um teste para calibrar a precisão.

Em fluxos de trabalho previsíveis, essa abordagem reduz o uso manual de tags e acelera a revisão, entregando seleções de alta qualidade que se alinham com os objetivos narrativos.

- Presets por conceito: categorizar as tomadas como cena, entrevista, ação, gráfico ou b-roll; capturar campos como lente, taxa de quadros, exposição, balanço de branco e espaço de cor.

- IA seleciona pontuação: anexe um valor de confiança e uma etiqueta de motivo (por exemplo, “arco narrativo forte” ou “ênfase visual”), permitindo que os revisores julguem de relance.

- Acesso à biblioteca: armazene trechos correspondentes em uma biblioteca centralizada; combinada com a integração do sora, os analistas podem cruzar referências de tomadas e tendências semelhantes.

A melhor prática envolve o refinamento de predefinições após uma execução de teste. A revisão assistida por IA demonstra economia de custos e redução de tempo, ao mesmo tempo que fornece assistência a especialistas.

Ajustar um conjunto de predefinição é simples: ajuste as categorias, modifique os campos de marcação e execute uma pequena amostra; os resultados fornecem orientação em relação à contagem de quadros e alinhamento com o roteiro ou storyboard.

Ao revisar as escolhas de IA, concentre-se em uma narrativa concisa: mantenha as tomadas que contribuem para a história, corte as tomadas redundantes e preserve as transições; use sobreposições gráficas para marcar as seleções e exporte uma lista curta para decisões de cor no set ou internas.

Dicas práticas de fluxo de trabalho:

- Ative o registro automático para cada clipe durante a captura para construir um banco de dados crescente.

- Realize a triagem assistida por IA com uma passagem separada para filtrar por humor, andamento e ritmo.

- Anote decisões em um campo de notas compartilhado para apoiar futuras sessões e colaboração com equipes de acesso.

- Avalie os resultados com um teste rápido usando uma pequena bobina; meça o tempo economizado e o valor agregado, não apenas a quantidade.

Os resultados incluem redução do trabalho manual, preparação mais rápida e uma biblioteca que suporta tendências e busca por projetos futuros; a lucratividade melhora à medida que o dinheiro economizado se acumula no pós.

Esta abordagem demonstra como jogadores de alto nível podem combinar pontuação impulsionada pela openai com estéticas de vanguarda; o tom e o ritmo guiam as seleções, mantendo um equilíbrio agradável entre variedade e coerência. Também oferece um caminho claro para equipes que otimizam valor e acesso em todos os departamentos.

Para equipes especializadas em narrativa concisa e orientada a dados, combinar predefinições com escolhas de IA oferece um caminho escalável para refinar os cortes, garantindo acesso a material de alta qualidade que se alinha com a narrativa da marca e os briefings do cliente. Equipes que se especializam em catalogação simplificada podem implementar fluxos de trabalho de otimização sem sacrificar a coesão narrativa.

Edições de montagem assistidas por IA: quando aceitar cortes brutos gerados por máquina

Comece com uma política concreta: aceite ai-assisted rough cuts para montagem inicial de sequências não críticas, usando um pronto-feito uma linha de base que as equipes podem usar para comparação. Designe um pequeno grupo de diretores, técnicos e animadores para validar a primeira versão e sinalizar cenas que precisam de intervenção humana.

Defina um limiar de aceitação claro: precisão de objetos posicionamento, tempo de imagem, e suave transicionando entre os tiros. Use algoritmos e métodos que se alinham com ideia de ritmo e humor, e validar continuamente os resultados em relação a uma referência. Documentar conhecimento para que as equipes possam definir expectativas e reutilizar uma abordagem consistente.

Critérios de escalonamento: quando ai-assisted output diverges from brand cues or pacing, or if partes discordam quanto ao humor, enter uma análise manual por diretores e animadores para refinar. Se o feedback mostrar desvio, eles deve ajustar os parâmetros ou mudar para pronto-feito alternativa.

Plano de lançamento: manter uma lacuna confortável entre cortes iniciais e edições finais; escolha para implantar pronto-feito baselines in multiple projetos; manter um cohesive conjunto de opções para seleção, permitindo mais rápido comparação e alinhamento mais rápido.

Dicas para adoção: comece com um pequeno lote de cenas; alinhe-se com o estilo de imagem; abrace smart ai-assisted processos; treinar equipes em conhecimento de como defina sucesso; continue phones perto para anotações e feedback rápidos; positivo atmosfera.

Conclusão: ai-assisted serve como uma ferramenta para auxiliar as tripulações, não como um substituto para a supervisão humana; por projeto, essa abordagem acelera seleção and assembly while remaining cohesive e confortável para equipes; a colaboração entre diretores, animadores e técnicos continua sendo essencial.

Ferramentas de gradação de cores adaptativas: integrando AI-match em pipelines de gradação técnica

Adote o AI-match como um plug-in dedicado, uma montagem entre formatos e mecanismo, entregando sugestões de aparência em tempo real, preservando os clipes.

Objetivo principal: reduzir o esforço manual de tentativa e erro, permitindo que as notas impulsionadas por algoritmos se alinhem às amostras de referência, utilizando informações coletadas de projetos anteriores e resultados entregues em diversos formatos.

Diversas entradas de drones e câmeras de mão alimentam um motor adaptativo, com prévias de zoom ajustável e linhas de cores analisadas em clipes, garantindo a continuidade emocional de cena a cena.

A integração no motor cria um caminho rápido e modular para modificar aparências, suporta varreduras interativas de parâmetros e retorna visualizações para revisões do cliente em tempo real, tipicamente com latência inferior a 150 ms em equipamentos padrão.

Avanços em IA apoiam os desenvolvedores ao desenvolver modelos que aprendem com dezenas de milhares de clipes (50k+), melhorando as correspondências e entregando aparências consistentes em sequências; isso reduz ajustes em muitos trabalhos.

Para clientes e equipes, os processos se tornam mais interativos, com alternâncias rápidas para modificar aparências, definir referências e comparar quadros lado a lado; você consegue auditar os resultados em si antes da entrega final.

Os formatos variam de masters em 8K a clipes proxy, com os looks entregues alinhados aos briefs; drones, esportes e filmagens cinematográficas se beneficiam da gradação adaptável que preserva linhas e equilíbrio tonal, ao mesmo tempo em que reduz o retrabalho.

Pontuações de confiança baseadas em fatos guiam quando aplicar sugestões de correspondência por IA, garantindo a integridade das cores e minimizando o excesso de suavização em diferentes gêneros, com pontuações típicas variando de 0,7 a 0,95 para projetos esportivos e documentários.

Desenvolvedores fornecem controles para ajustes rápidos, prévias de nível de zoom e uma integração habilitada para montagem que se alinha com pipelines existentes, permitindo colaboração em tempo real com clientes.

Práticas de avaliação contínua permitem que os cineastas revisem os resultados por si mesmos, enquanto os avanços da IA impulsionam tempos de resposta mais rápidos, deslocando o foco de tarefas mundanas para decisões criativas em todas as funções.

Speech-to-text, legendas e localização: definição de limiares de precisão e etapas de controle de qualidade

Recomendação: Defina metas claras de precisão para legendas e legendas geradas por ASR, além de uma hierarquia de controle de qualidade. Áudio de estúdio: WER ≤ 6%, pontuação 95–98%, desvio de tempo ≤ 0,25 s por dica; gravações externas: WER ≤ 8%, pontuação 90–95%, desvio ≤ 0,30 s. Use um algoritmo ASR, registre correções rápidas e ajuste os limites com dados de campanhas. Isso ajuda a manter resultados de alta qualidade em gravações diversas, abordando se o conteúdo toca em política ou mensagens gerais, e apoia o alcance a longo prazo.

As camadas de QC combinam automação, revisão humana e validação de localização. Verificações automatizadas analisam pontuações de confiança, comprimentos de pistas e consistência de pontuação; etapas de QC robóticas lidam com verificações repetitivas, liberando especialistas para se concentrarem em nuances e funções essenciais; a revisão humana sinaliza emoções mal interpretadas, rótulos de falante incorretos e dessincronizações; a validação de localização testa a cobertura do glossário, referências culturais e fidelidade de retradução. Agende a verificação por arquivo, além de revisões em lote para campanhas com vários idiomas.

Dicas operacionais para integração: alinhe as legendas à regra dos terços para legibilidade em telas pequenas, mantenha quebras de linha curtas e ajuste a duração por dica para evitar aglomerações. Mantenha um glossário dinâmico, vinculando gírias, termos de marca e nomes de produtos a transcrições consistentes; ajuste as curvas do tempo para o ritmo da fala em locuções e entrevistas para minimizar sobreposições. Use automação para sinalizar casos extremos, mas confie em especialistas e pessoas no set para aprovar o conteúdo antes da publicação.

Governança de dados e melhoria a longo prazo: registre cada métrica, acompanhe a derivação em campanhas e alimente insights em pipelines de localização downstream. Garanta que os públicos em smartphones ou desktops recebam experiências perfeitas; meça as mudanças no alcance e no engajamento após as atualizações de legendas. Emoções e tom devem corresponder aos visuais para que os espectadores percebam autenticidade, não narração robótica. Diretores, produtores, linguistas e pessoas no set devem colaborar para resolver mal-entendidos no início.

| Aspecto | Métrica alvo | Etapa de QC | Frequência | Proprietário |

|---|---|---|---|---|

| Precisão do ASR | WER ≤ 6% (estúdio); ≤ 8% (campo) | Verificações automatizadas; pontuação de confiança; verificação cruzada com a verdade fundamental | Por arquivo | Especialistas |

| Tempo de legenda | Deriva ≤ 0,25 s por dica | Ajuste de tempo; ajuste manual se necessário | Por trecho | Líder de QC |

| Qualidade de localização | Cobertura do glossário > 85%; fidelidade da retradução | Verificação de glossário; verificações de retradução | Por campanha | Equipa de localização |

| Emoção e pontuação | Acurácia da pontuação 95–98%; pistas de emoção alinhadas com visuais | Revisão humana com foco no alinhamento de emoções; marcação de pontuação | Por lote | Diretores, linguistas |

| Consistência entre idiomas | Quebras de linha e fraseado consistentes | QA entre linguagens; testes em legendas de postagens de mídia social | Semanal | Engenheiros |

Etiquetagem de ativos e busca: projetando esquemas de metadados para mídia organizada por IA

Adote um esquema de metadados em camadas ancorado em campos principais e uma taxonomia de marcação flexível para otimizar a organização e a precisão da pesquisa orientadas por IA. A estrutura compreende três camadas: metadados estruturais (asset_id, projeto), metadados descritivos (título, descrição, composições) e metadados administrativos (direitos, proveniência, versão). Defina um conjunto de termos prático que mapeie diferentes contextos. Essa abordagem se torna indispensável para equipes que executam recuperação rápida e mantêm a consistência em uma biblioteca de ativos. Essa abordagem possibilita o alinhamento rápido das equipes.

Os campos principais devem incluir asset_id, filename, project, scene, compositions, shot_number, timecode, location, color_space, resolution, frame_rate, camera_model, lens, exposure, audio_id, licensing, access_rights.

A taxonomia de tags deve ser equilibrada, com categorias amplas (assunto, humor, gênero) e termos granulares (objeto, pessoa, ação, técnica). Mantenha a consistência com as convenções de nomenclatura; garanta a consistência em todas as categorias e evite desvios. Uma hierarquia bem estruturada suporta filtragem rápida e interconexão entre ativos; as relações entre as tags ajudam a vincular cenas e sequências.

Fluxo de trabalho de etiquetagem assistido por IA: passagens iniciais por modelos treinados em dados do domínio; revisão humana para corrigir etiquetagem incorreta; ajustes tornam-se parte do aprendizado contínuo. Use embeddings para conectar descrições, composições e dicas visuais; habilite a pesquisa por conceito, estilo ou humor; possível combinar dicas textuais com impressões digitais visuais para referenciamento cruzado.

Design de interface de busca: suporte a consultas booleanas e em linguagem natural; habilitar filtros por data, localização, assunto, composição; incluir preenchimento automático e sugestões de tags; rastrear métricas de uso para otimizar o esquema; observar vieses e lacunas; a tecnologia se torna uma parceira na descoberta.

Governança e colaboração entre equipes: estabelecer responsabilidade, política de gestão de metadados; designar responsáveis por dados líderes; criar convenções de nomenclatura; existir como uma prática consistente entre equipes; fornecer treinamento; ajudando editores e produtores a alinhar posicionamento e expectativas; relacionamentos entre grupos fortalecem a disciplina de marcação. Se você está integrando metadados em fluxos de trabalho, comece com um piloto em um único departamento.

Otimização e preparação para o futuro: projete esquemas para acomodar novos tipos de mídia; habilite extensões; adote versionamento; suporte à interoperabilidade entre plataformas; busque remover tags obsoletas; garanta um histórico de precisão a longo prazo; fique atento a desempenho instável em pipelines enxutos; agende ajustes conforme necessário; torne os ajustes possíveis para formatos futuros.

Resultados e foco: recuperação mais rápida para diferentes tipos de ativos; acesso mais fácil a composições; melhor reutilização em projetos; fluxos de trabalho orientados a metadados permitem originalidade em edições e narrativa; os relacionamentos resultantes entre as equipes se tornam mais produtivos e coerentes; possibilitado por uma etiquetagem e pesquisa disciplinadas.

Controle de qualidade de correções de IA (estabilização, upscaling, remoção de ruído): identificação de modos de falha típicos

Comece com um plano de QA impulsionado por experimentos. Execute um piloto automatizado em um conjunto representativo de filmagens para revelar modos de falha sob as etapas de estabilização, ampliação e remoção de ruído. Gere formulários concisos para que os técnicos documentem observações, sinalizações e correções propostas. Isso sustenta um fluxo de trabalho estruturado que mantém as empresas competitivas, encurtando os loops de feedback e capacitando os profissionais a agir rapidamente.

- Instabilidade temporal: cintilação, tremor quadro a quadro ou movimento inconsistente após a estabilização que quebra a continuidade em sequências.

- Artefatos de halo e borda: halos ao redor de bordas de alto contraste, anelamento ou fronteiras artificiais introduzidas por nitidez ou aumento de escala.

- Erosão da textura: perda da estrutura fina em pele, tecido ou obra de arte; a identidade pode desvanecer-se quando os detalhes faciais desaparecem ou deslocam-se subtilmente.

- Over-denoising: pele plástica, texturas borradas ou microdetalhes suavizados que reduzem a profundidade e o realismo percebidos.

- Defeitos de upscaling: manchas de textura, padrões de tabuleiro de xadrez ou sangramento de cores em regiões ampliadas onde a resolução original é insuficiente.

- Cor e deriva de WB: equilíbrio de cores inconsistente entre tomadas ou dentro de uma cena única, alterando o humor e a continuidade.

- Inconsistência de cor temporal: mudanças de cor de quadro em quadro que perturbam o ritmo de visualização, especialmente em planos longos.

- Problemas de identidade facial e corporal: desalinhamento de pontos de referência, movimentos naturais dos olhos ou da boca, ou proporções alteradas durante o aumento de escala ou estabilização.

- Falhas na separação de primeiro plano e fundo: sangramento nas bordas entre o objeto e o fundo, causando fantasmas ou contornos suaves.

- Erros de interpolação de movimento: movimento borrado, quadros fantasma ou movimento acelerado que parece artificial ou estranho.

- Representação incorreta da textura em baixa luminosidade: padrões de ruído amplificados ou grão falso que não combinam com a qualidade geral e a iluminação.

- Artefatos de logotipo e gráficos: aliasing ou desalinhamento próximo a sobreposições, títulos ou terços inferiores após o processamento.

- Inconsistência temporal em padrões de ruído: incompatibilidade da textura de ruído através de transições de sequência, reduzindo a continuidade.

Abordagens de detecção para identificar falhas diariamente incluem: diffs automatizados contra referências, SSIM e métricas perceptivas, e pontuações de anomalias em nível de quadro. Use verificações de identidade por tiro para garantir que os pontos de referência faciais e as proporções do corpo permaneçam estáveis em correções, e implante mapas de diferença para localizar visualmente artefatos. Mantenha um registro sob formulários com carimbo de data/hora, ID do tiro e um veredicto para permitir comparações rápidas entre versões anteriores e atuais.

- Estabelecer critérios de aceitação para cada forma de correção (estabilização, aprimoramento, remoção de ruído), com foco na continuidade, integridade da textura e fidelidade das cores.

- Atribuir funções a técnicos e operadores para rodadas de revisão; rodízio de revisores para evitar viés e ampliar a cultura de feedback.

- Realize experimentos repetíveis com material diverso, incluindo videoclipes musicais, filmagens de documentários e cenas inspiradas em obras de arte, para expor casos de borda.

- Mantenha os casos organizados por tipo de falha; gere uma base de conhecimento que as equipes possam consultar antes de implantações subsequentes.

- Desenvolver um protocolo de diferença rápida: se um frame se desviar além de um limite predefinido, encaminhá-lo para o QA manual em vez de uma aprovação/reprovação automática.

Remediação e melhorias de processo focam em iterações mais rápidas e seguras. Crie um pipeline padronizado onde as passagens automatizadas sinalizam frames suspeitos, seguidas por verificações manuais direcionadas. Essa abordagem ajuda a diferenciar ganhos rápidos de refinamentos cautelosos, preservando a identidade e a intenção artística, ao mesmo tempo em que mantém a segurança para as produções. Inclua exemplos de projetos de cineastas e cenários de preservação de obras de arte para ilustrar como as correções impactam a cultura, a identidade e a percepção geral da obra.

Recomendações práticas para melhoria contínua:

- Incorpore ciclos orientados a experimentos nas rotinas diárias; documente os resultados em uma biblioteca de casos para referência.

- Realize revisões regulares com um grupo diversificado de profissionais, incluindo mulheres, para garantir perspectivas equilibradas e qualidade robusta.

- Mantenha backups, carretéis versionados e logs rastreáveis para proteger a segurança e a procedência da obra de arte.

- Invista em treinamento estruturado para técnicos e equipe de operadores aprimorar as habilidades de diagnóstico e correção.

- Alinhar correções com um objetivo claro de preservação da identidade, ao mesmo tempo em que se exploram as possibilidades oferecidas por ferramentas automatizadas.

O Impacto da IA na Edição de Videografia – Mudança de Funções, Habilidades e Fluxos de Trabalho" >

O Impacto da IA na Edição de Videografia – Mudança de Funções, Habilidades e Fluxos de Trabalho" >