추천: Begin every AI-driven marketing content creation with a risk audit; embed privacy-by-design into the model lifecycle; ensure data handling complies with regulations; align with the brand’s values.

To address bias, misuse, establish a governance framework; monitor impact on audiences across regions; use 깨끗하다 data; institute risk controls before publishing polished outputs for a campaign.

However, whether signals arise from first-party input or third-party sources; the process must uphold consent, transparency; accountability stays central; align with regulations 전 세계적으로; protect consumer trust; boost brand integrity.

What matters for business creation is human oversight within the loop; provide clear explanations for model choices regarding sensitive topics; publish lightweight summaries for stakeholders to inspect.

During browsing data usage, keep pipelines 깨끗하다; maintain an auditable trail; address bias risk; measure impact on brand perception 전 세계적으로.

참고: This framework should be revisited quarterly; policy updates must reflect evolving regulations; the result is a polished governance posture that brands can rely on when shaping messaging, responsibly.

Guidelines for Ethical and Responsible AI in Advertising

Deploy a risk screen before releasing any automated asset to the market; assign a cross-functional owner; require a sign-off that the plan reduces harms to individuals, groups; protect environmental integrity; set concrete remediation timelines for any failures; align with clearly stated expectations across workflows.

Audit data provenance; limit dependence on third-party sources lacking transparency; rely on verifiable signals wherever possible; implement bias checks; install guardrails; enable drift monitoring; require periodic revalidation against evolving industry practices; teams can find gaps via automated testing; track legally compliant status.

In video generation pipelines, verify produced clips do not spread misinformation; avoid manipulative micro-targeting; document the model behaviour; provide user controls; test representations across demographics; consider fashion industry sensitivities; ensure what the system yields meets published expectations for accuracy; check for fairness; implement rapid issue resolution when problems appear.

Governance and legal alignment: ensure compliance with legally binding standards across jurisdictions; define clear workflows for model release, risk approvals, vendor audits; monitor third-party tools for best practices; maintain versioning logs; require vermette and gpt-5 integration checks; implement network segmentation to limit data exposure; establish provenance trails for each asset.

Measurement and accountability: set metrics to evaluate performance against expectations; monitor harms, misinformation risk, speed; rely on independent audits; provide transparent reporting; allow individuals to request corrections; maintain a full audit trail; tailor assessments to industries like fashion; ensure the network meets legally required standards; the system gets real-time updates on key indicators.

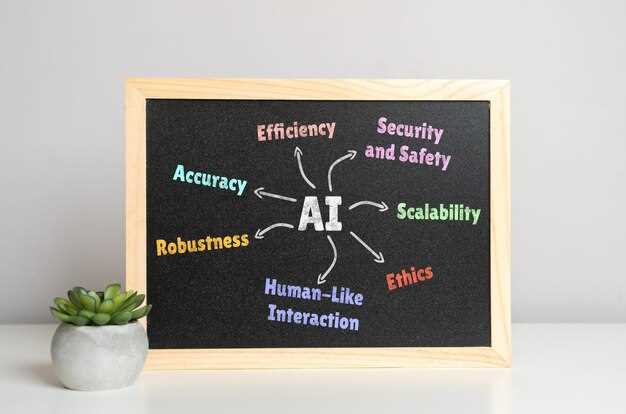

Defining ‘Ethical’ and ‘Responsible’ AI in Advertising

Start with a binding policy for every campaign: pause pipelines when risk thresholds are met; document decisions; implement guardrails that block processing of sensitive inputs.

Define criteria that exist within a collection of algorithms; an instance of misalignment triggers review; keep privacy rules separate from creative aims.

Anchor data practices with provenance; avoid sources that violate consent; maintain a collection of references; guard against blurring lines between signal and noise; water-like ambiguity must be minimized; providing helping transparency to stakeholders.

Run red-team tests using gpt-5 to surface likely real-world scenarios; times when outputs become inaccurate must trigger immediate human review; training iterations should address those gaps.

Defining polished metrics requires transparent governance; track model behavior against a published message about limits; provide example scenarios; think in cycles about training adjustments; however, updates occur as new data exist; designs should be measured against risk, with algorithms calibrated accordingly.

How to detect and remove algorithmic bias in audience segmentation

Begin with a concrete audit: run the model on a holdout set stratified by age; geography; device; income; report performance gaps in audience segmentation; map outcomes to real-world implications for users.

Compute metrics such as demographic parity; equalized odds; extend with calibration error by subgroup; document whether absence of parity exists across related cohorts; maintain a transparent log of results.

Addressed biases require adjustments at data intake; feature selection; thresholding; lower proxy risk by removing sensitive proxies; diversify data collection sources; reweight signals for underrepresented groups; rerun tests to verify effect.

Maintain transparency with stakeholders: publish a concise model understanding; share the market message without oversimplification; surface biases in narratives used by campaign teams; show which segments receive reach, which miss out. In real-world campaigns, advertisements can mask bias unless transparency remains.

Ideation to implementation: design experiments that test new feature sets; run A/B tests with balanced exposure; set stop criteria when a gap exceeds predefined thresholds.

Real-world practice: allow users to opt into tailored experiences; they can measure satisfaction; once bias detected, ensure absence of manipulation; theres room for improvement.

Mitigate bias speed: measure how they work under live conditions; the importance grows as exposure expands; implement continuous monitoring; deploy lightweight dashboards; review at quarterly intervals; over years, breakthroughs accrue when governance remains strict; saying results openly boosts trust.

Closing note: youre team should embed these steps into an operating model; prioritize fairness across segments; measure impact on business outcomes while preserving transparency.

Which user data to collect, anonymize, or avoid for ad personalization

Recommendation: collect only basic identifiers essential for relevance; anonymize immediately; keep signals hashed or aggregated.

Exclude sensitive attributes such as health status, political beliefs, race, religion, or precise location unless explicit informed consent exists.

In cases like adidas campaigns, nicole from the analytics team notes measured gains; a polished approach yields results with lower risk; last mile signals stay within the model; using only non-identifiable data helps preserve trust.

Markets with strict privacy rules require tighter controls; limit scope of data by design; erode risk through phased data retention; know which signals remain useful, which stops sooner, which expire last.

Report back to the team with clear rationale for each data type; inform stakeholders how data moves from collection to anonymization; this keeps the ability to adapt algorithms stronger while remaining compliant.

Every step should be documented, including which data consumes resources, which remains aggregated, which is discarded; this clarity supports informed decisions across large market teams.

Tables provide a polished reference for cases, including large markets; the following table outlines data categories, treatment, and recommended usage.

| Data Type | Anonymization / Handling | Recommended Use |

|---|---|---|

| Personal identifiers (emails, phone, user IDs) | Hashing, tokenization, pseudonymization; restrict linkage across sessions | Support cross-session relevance without exposing identity; report results to the team |

| 위치 데이터 (정밀 GPS, 거리 수준) | 도시 수준 또는 지역으로 집계하고, 정확한 좌표는 삭제합니다. | 오프라인-온라인 캠페인에서 특히 시장에서의 맥락적 관련성 |

| 기기 식별자 (IDFA/GAID) | 토큰을 회전시키고, 개인 정보 보호 변환을 적용합니다. | 빈도 제한, 신규 노출 페이싱, 코호트 분석 |

| 행동 신호 (조회된 페이지, 상호작용) | 집계된, 코호트 기반 요약; 원시 로그는 피하십시오. | 개인 정보 보호 모델 내의 개인화 |

| 인구 통계(연령대, 광범위한 세그먼트) | 거친 세분화; Opt-in 방식만, 명확한 동의어 사용 | 세분화된 사용자 프로파일링 없이 세그먼트 레벨 맞춤 설정 |

| 민감한 속성 (건강, 정치적 견해) | 명시적인 정보 동의가 없는 경우 삭제합니다. 엄격한 접근 제어로 별도로 보관합니다. | 드물게, 강력한 정당성과 감독이 있을 때만 |

| Third-party data | 제한하거나 제외합니다. 자체 신호 우선 사용 | 위험을 줄이고, 소비자 및 시장의 신뢰를 유지합니다. |

| 옵트인 신호 | 출처를 명확하게 유지하고, 철회 요청을 존중하십시오. | 원칙에 기반한 개인화, 사용자가 제어 |

시장 목표는 투명성에 달려 있습니다. 보고서 지표를 명확하게 보고합니다. 검증 가능한 출처로 최후의 마일 결정 정보를 알립니다. 팀은 신원을 노출하지 않고도 알고리즘을 조정할 수 있습니다.

소비자에게 AI 사용을 공개하지 않고도 캠페인 성과를 해치지 않는 방법

소비자 대상 콘텐츠에서 AI 사용 사실을 콘텐츠 시작 부분에 간결하고 명확하게 밝힙니다. 이를 통해 오해를 줄이고, 신뢰를 구축하며, 인간 창작자의 공헌을 보호하고, 팀을 역량 강화합니다.

- 투명한 공개 문구: “AI 보조를 통해 제작됨” 또는 “AI 생성 콘텐츠”를 사용하세요. 간결하게 작성하고 광고의 첫 번째 프레임이나 동영상 캡션에 배치하세요. 평이한 언어로 이러한 공개를 하면 오해를 줄일 수 있으며, 이 접근 방식은 개인이 출처를 이해하는 데 도움을 주면서 저작권 분쟁을 피할 수 있습니다.

- 배치 전략: 눈에 잘 띄게, 헤드라인 근처에 배치합니다. 비디오 오버레이의 경우, 주요 메시지가 시작되기 1초 전에 캡션을 표시합니다. 공개 속도가 중요합니다. 모호함은 있을 수 없습니다. 시청자를 알리기 위해 광고에 이 공개 내용을 적용합니다.

- 팀, 제작자, 데이터 팀에 대한 공헌: 개념을 형성하는 데 기여한 사람들을 언급합니다. 이는 책임을 명확히 하고 관련된 전문가들에게 공헌을 보존합니다. 그들의 전문성은 비즈니스를 지원하고 고객과의 연속성을 보장합니다.

- 저작권 보호 및 위험 관리: 입력은 라이선스가 있는 소스에서 가져와야 합니다. 생성된 출력에는 인간 검토관에 의해 확인되지 않는 한 저작권 침해의 위험이 있습니다. 게시하기 전에 인간 검토를 수행하십시오. 위반을 방지하기 위해 출처를 문서화하십시오.

- 편향된 콘텐츠 완화: 편향된 묘사에 대한 테스트 출력; 안전장치 구현; 다양한 프롬프트 사용, 다양한 배경의 리뷰 패널; 편향된 표현의 위험을 줄입니다. 특히 글로벌 배포 캠페인의 경우 더욱 그렇습니다.

- 현지화 및 어조 제어: 지역별로 공개 사항 맞춤 설정; 일부 시장에서는 특정 어휘가 필요합니다. 제작자 팀에서 시작한 캠페인 전체에서 일관성을 유지합니다. 투명성을 유지하면서 브랜드 목소리를 보존합니다.

- 측정 계획: 공개된 변형과 공개되지 않은 변형을 비교하는 통제된 테스트를 실행하고, 재현율, 신뢰도 향상, CTR, 전환율, 브랜드 감정과 같은 지표를 추적하며, 투명성을 희생하지 않고 결과에 따라 예산을 조정합니다.

- 구현 개요: 팀은 프로세스를 개요화합니다. 크리에이티브, 데이터 과학자, 법무, 고객에게 역할을 할당합니다. 자산 전반의 규정 준수를 보장하기 위해 점검 목록을 정의합니다. 이 워크플로우를 구현하면 재작업 속도와 위험이 줄어듭니다.

- 고객 커뮤니케이션 및 프로세스 정렬: 위험 완화 계획을 제시하고, 성과, 법적 책임, 브랜드 안전에 대한 우려 사항을 해결하며, 대규모 롤아웃 전에 고객과 정렬을 보장합니다.

- 과제 및 지속적인 개선: 허위 정보 위험 모니터링; 출력물이 브랜드 표준에서 벗어날 경우 대체 옵션 구축; 모델 발전에 따른 업데이트 계획; 거버넌스는 엄격하게 유지; 이러한 관행은 표준이 되고 있습니다.

누가 책임이 있는가: AI 결정에 대한 인간의 확인 및 감사 추적 할당

추천: 청중 노출에 영향을 미치는 모든 AI 기반 결정에 대한 인간의 확인을 의무화합니다. 입력, 모델 버전, 데이터 출처, 타임스탬프, 결정 근거, 릴리스 상태가 포함된 감사 가능한 로그를 구현합니다. 모든 것의 추적 가능성을 보장하기 위해 배포 전에 권한 게이트를 설정합니다.

책임 소재를 명확하게 정의합니다. 각 배포에 대해 명명된 담당자가 승인하도록 합니다. 충돌이 발생할 경우를 대비한 대체 검토자를 포함하고, 감사 및 규정 준수 팀의 접근이 가능한 중앙 집중식 저장소에 마지막 서명인 및 승인 기록을 보관합니다.

감사 추적 기록은 범위, 모델 버전, 데이터 계보, 입력 프롬프트, 위험 플래그, 출력, 소비자 영향 등을 캡처해야 하며, 위변조 방지를 위해 불변 저장, 타임스탬핑, 별도의 접근 역할 보장을 확인해야 합니다.

작업 흐름 전반에 걸쳐 거버넌스를 통합하고, 실제 캠페인과 연계하며, 조작된 결과물을 피하고, 필요할 때 외부 검토를 포함하며, 광고의 창의적 콘텐츠에 대한 고유한 검사를 유지하십시오.

거버넌스를 위해 지표가 중요합니다. 청중에게 미치는 결과, 브랜드 평판을 측정하고, 수년에 걸쳐 성과를 추적하며, 위험 변화를 예측하고, 과거 캠페인에서 얻은 교훈이 향후 조치를 알리도록 학습 루프를 보장합니다.

모델 카드 아티팩트를 채택하고 데이터 소스, 학습 체제, 한계에 대한 지식을 포함하며, 조작된 콘텐츠에 대한 검사를 설정하고, 작업 흐름의 일관성을 유지하도록 통합된 지식 흐름을 유지하고, 잠재적 위험에 대한 경고 라벨을 발행합니다. 이를 통해 조언 팀이 실제 맥락에서 가치를 창출하는 데 도움이 될 것입니다.

권한 제어는 오용을 방지해야 합니다. 고위험 사용 사례에 대한 최종 승인을 설계하고, 투명성을 저해하지 않으면서 기술 발전에 대비하며, 감사 (監査)가 선택 사항이 아닌 일상이 되는 미래에 대비해야 합니다.

서명 부재는 표류를 초래합니다. 자동화에 대한 반론은 인간의 감독을 통해 나타납니다. 팀을 지원하기 위해 조언과 제작 프로세스를 통합하십시오. 실제 캠페인 전반에 걸쳐 지식을 접근 가능하게 유지하십시오.

타겟팅 및 입찰을 위한 측정 가능한 공정성 제약 조건 및 절충점을 설정

타겟팅, 입찰, 캡핑에 대한 정량화 가능한 공정성 예산을 구현하여 정의된 그룹 간의 기본 할당 편차를 벗어나지 않도록 합니다. 재고 풀별로 매일, 웹사이트별로, 대행사, 마켓플레이스 등을 포함한 파트너 네트워크 내에서 측정합니다. 이 예산을 사용하여 마케팅팀은 할당을 신속하게 조정할 수 있습니다.

정밀도와 형평성 간의 균형 곡선을 정의하고, 노출 차이에 대한 구체적인 상한선을 백분율 포인트로 설정하며, 성과가 부진한 세그먼트에 대한 재고를 재할당하십시오.

정렬 불일치 모니터링 지표: 청중 불일치; 클릭 품질; 전환 속도; 조작 신호; 잠재적 오도에 대한 웹사이트, 인벤토리 소스, 시각 자료 검사.

네트워크 내에서 생성된 콘텐츠 보호: 저작권이 있는 시각 자료 제한; 딥페이크 자료 감지; 파트너 템플릿 내에서 제작된 정제되고 독창적인 자산 시행; 워터마킹 구현.

위험 점검을 위한 워크플로 설계; 제안된 창의물이 편향을 야기하는지 질문; 라이브 배포 전에 승인 요구; 감사 로그 유지.

웹사이트 전체의 재고를 매핑하고, 대행사, 마켓플레이스, 판매자와 협력하며, 자산이 합법적인 출처에서 비롯되었는지 확인하고, 노출 추적을 위해 데이터 태깅을 구현하고, 허위 정보에 대한 방어 조치를 취합니다.

gpt-5; 테스트 프롬프트는 생성된 시각적 요소에 영향을 미칩니다; gpt-5 외의 다른 모델 사용.

예시: 시각적 진위성 신호, 메타데이터, 재고 태깅을 포함하여 노출을 추적하는 다듬어진 템플릿을 채택합니다. 오표기를 피하기 위해 프롬프트를 모니터링합니다.

기관, 출판사, 마케터 간의 협력: 오정보, 신호 소실과 같은 문제 해결; 캠페인 전반의 오정보 감소; 웹사이트 전반에 걸친 신속한 검토; 학습 내용 공유.

예시 값들은 인벤토리, 웹사이트 전반에 걸쳐 캠페인에 대한 기본 공정성 수준을 보여줍니다.

보고서: 공정성 지표, 절충안, 위험 수준을 보여주는 완성도 높은 대시보드를 제작합니다. 시각 자료, 데이터, 트렌드를 포함합니다.

단 하나의 레시피는 없습니다. 목표에 부합하는 접근 방식이 무엇이든 좋습니다.

공정성 제약 조건에 대한 점진적인 업데이트에는 제안된 가치가 있습니다.

광고에서의 윤리적이고 책임감 있는 AI 사용 — 지침" >

광고에서의 윤리적이고 책임감 있는 AI 사용 — 지침" >