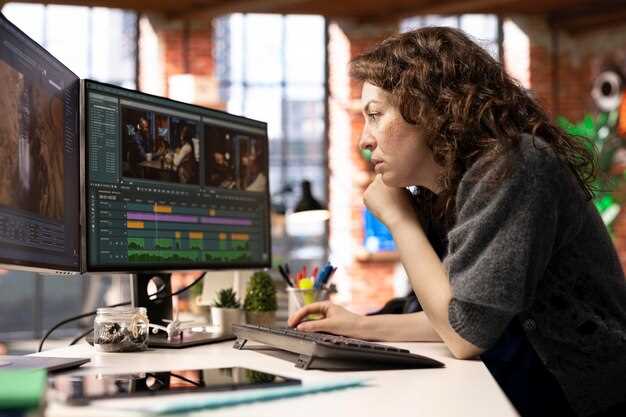

Raccomandazioneintegrare strumenti accelerati dall'intelligenza artificiale per automatizzare attività ripetitive, consentendo ai professionisti di dedicare gran parte del loro tempo alla creazione di storie visive che risuonano con il pubblico. definitivamente adatto a team che tradizionalmente si affidavano a rifiniture manuali, pur mantenendo l'attenzione sulla qualità essenziale e rispettando le scadenze ravvicinate.

L'IA rimodella le mansioni all'interno della post-produzione spostando correzioni colore di routine, etichettatura di risorse e decisioni di montaggio approssimativo in cicli automatizzati. Questo articolo evidenzia come costruire percorsi di audit trasparenti e controlli umani nel ciclo durante i test pilota per garantire la sensibilità al tono e alle sfumature nonostante i vincoli; questo minimizza la deriva tra le scene. Regolare riunioni con l'aiuto di clienti e stakeholder navigare aspettative e accelerare i cicli dal brief alla consegna.

Per professionisti che desiderano migliorare, quattro passi pratici: (1) crea una libreria di preset assistiti dall'AI per colore, stabilizzazione, generazione di sottotitoli e animazione; (2) allinea la crescita delle abilità attorno a animazione e sound design per supportare tagli automatici; (3) definire essenziale metriche per giudicare la qualità dell'output oltre la velocità; (4) esegui riunioni con clienti per allineare le aspettative. Questo approccio tradizionalmente fits business needs mentre preservando l'intento creativo.

In questo articolo, i primi piloti mostrano guadagni: enorme riduzioni dei tempi di primo taglio e maggiore coerenza dei metadati. In pratica, l'etichettatura assistita dall'IA e i suggerimenti di rough-grade possono ridurre le passaggi iterativi di much e migliorare la collaborazione con audiences. La sensibilità to narrative arc èè vitale; gli umani dovrebbero esaminare attentamente i fotogrammi critici, soprattutto nelle scene di conflitto. Durante la pianificazione, testare su un progetto rappresentativo per misurare l'impatto e iterare.

Considerazioni per l'adozione includono il rischio di deriva creativa, la governance dei dati, le licenze per gli asset generati e l'allineamento con le tempistiche del cliente. Stabilire una chiara titolarità per gli output dell'IA e impostare delle linee guida per colore, ritmo e sound design. In pratica, mantieni un team ridotto produzione pipeline and riunioni con le parti interessate per calibrare i progressi; questo approccio aiuta i team navigare aspettative e offrire valore ai clienti espandendo al contempo la portata con il pubblico.

Cambiamenti concreti nelle responsabilità dell'editor e nelle attività quotidiane

Stabilire un ciclo di editing modulare che si basa su preset di movimento e risorse stock per ridurre drasticamente le modifiche di routine, spingendo i progetti verso i traguardi di consegna con facilità.

Crea una libreria centralizzata condivisa dai team di collaboratori, consentendo di curare migliaia di clip con il minimo attrito, mentre i videografi forniscono materiale direttamente dal luogo di ripresa.

Smantella le linee temporali tradizionali combinando dinamicamente elementi di creazione, consentendo di riassemblare scelte di colore e sequenze di movimento in pochi secondi.

Definire passaggi che richiedono collaborazione con i marketer per affrontare lo spostamento di responsabilità e garantire che le scorte e le risorse create rispondano agli obiettivi della campagna.

Decisioni di taglio ripetitive scartate lasciano il posto a scelte basate sui dati; un elenco di segnali provenienti da analisi guida questo team verso output più rapidi e coerenti.

Showcase dei progetti evidenziano come migliaia di stakeholder percepiscono movimento, colori e ritmo; conoscere gli umori del pubblico modella una danza tra tagli, aiutando i videografi e i marketer ad allinearsi su una singola visione.

la rivoluzione avanza, interrompe i processi tradizionali, richiedendo una curatela disciplinata e l'ascolto del feedback dei collaboratori; questa realtà spinge migliaia di creatori ad adattarsi.

Automated logging e selezione di clip: configurazione di preset e revisione delle scelte dell'IA

Configura preset per autologgare automaticamente i metadati essenziali per ogni clip, inclusi tipo di ripresa, posizione, riprese e durata; assegna un punteggio di confidenza alle scelte dell'IA ed esegui una prova per calibrare la precisione.

Nei flussi di lavoro prevedibili, questo approccio riduce l'etichettatura manuale e velocizza la revisione, offrendo selezioni di alta qualità che si allineano con gli obiettivi narrativi.

- Impostazioni predefinite per concetto: categorizzare le riprese come scena, intervista, azione, grafica o b-roll; acquisire campi quali obiettivo, frequenza fotogrammi, esposizione, bilanciamento del bianco e spazio colore.

- L'IA seleziona i punteggi: associa un valore di confidenza e un tag di motivo (ad esempio, “arco narrativo forte” o “enfasi visiva”), consentendo ai revisori di giudicare a colpo d'occhio.

- Accesso alla libreria: memorizzare clip corrispondenti in una libreria centralizzata; combinato con l'integrazione di sora, gli analisti possono confrontare scatti e tendenze simili.

La best practice prevede l'affinamento delle impostazioni predefinite dopo una prova. La revisione assistita dall'IA dimostra risparmi sui costi e riduzione dei tempi, fornendo al contempo assistenza agli specialisti.

Regolare un preset è semplice: modificare le categorie, modificare i campi di tag e rieseguire un piccolo campione; i risultati forniscono indicazioni sul numero di scatti e sull'allineamento con la sceneggiatura o lo storyboard.

Quando si esaminano le scelte dell'IA, concentrati su una narrazione compatta: mantieni le riprese che contribuiscono all'arco narrativo, taglia le riprese ridondanti e preserva le transizioni; utilizza sovrapposizioni grafiche per contrassegnare le selezioni ed esporta una breve lista per decisioni di color grading in set o interne.

Consigli pratici per il flusso di lavoro:

- Attiva la registrazione automatica per ogni clip durante la cattura per creare un database in continua crescita.

- Esegui uno screening assistito dall'intelligenza artificiale con una passata separata per filtrare per umore, tempo e ritmo.

- Annotare le decisioni in un campo di note condiviso per supportare sessioni future e la collaborazione con i team di accesso.

- Valuta i risultati con una prova rapida utilizzando una piccola bobina; misura il tempo risparmiato e il valore aggiunto, non solo la quantità.

I risultati includono una riduzione del lavoro manuale, una preparazione più rapida e una libreria che supporta le tendenze e la ricerca per i progetti futuri; la redditività migliora man mano che i risparmi si compattano nel periodo successivo.

Questo approccio dimostra come i giocatori di alto livello possano combinare valutazioni basate su openai con estetiche d'avanguardia; il tono e il ritmo guidano le selezioni mantenendo un piacevole equilibrio tra varietà e coesione. Offre inoltre un percorso chiaro per i team che ottimizzano il valore e l'accesso tra i reparti.

Per team specializzate in storytelling concisi e basati sui dati, combinare preset con scelte dell'IA offre un percorso scalabile per perfezionare gli scatti, garantendo l'accesso a materiale di alta qualità che si allinea alla narrativa del marchio e alle richieste dei clienti. Team che si specializzano in catalogazione semplificata possono implementare flussi di lavoro di ottimizzazione senza sacrificare la coesione narrativa.

Modifiche all'assemblaggio assistite dall'IA: quando accettare bozze approssimative generate dalla macchina

Inizia con una politica concreta: accetta ai-assisted tagli approssimativi per il montaggio iniziale di sequenze non critiche, utilizzando una già pronti linea di base a cui i team possono fare riferimento. Assegnare un piccolo gruppo di direttori, tecnici e animatori per validare la prima bozza e segnalare le scene che necessitano di input umano.

Definisci una chiara soglia di accettazione: accuratezza di oggetti posizionamento, tempistica di imagery, e liscia transitioning tra le riprese. Usa algoritmi and metodi che si allineano con idea di ritmo e umore, e continuamente validare i risultati rispetto a un riferimento. Documentare knowledge così i team possono definire le aspettative e riutilizzare un approccio coerente.

Criteri di escalation: quando ai-assisted output diverges from brand cues or pacing, or if feste disagree on mood, enter un controllo manuale da parte di registi e animatori per raffinare. Se il feedback mostra deviazioni, loro should adjust either parameters or switch to già pronti alternative.

Piano di rilascio: mantenere un margine confortevole tra le bozze grezze e le modifiche finali; scegli per distribuire già pronti baselines in multiple projects; keep a cohesive set di opzioni per selezione, consentendo più veloce confronto e un allineamento più rapido.

Tips for adoption: start with a small batch of scenes; align with imagery style; embrace smart ai-assisted processes; train teams on knowledge di come definisci successo; continua telefoni vicino per note e feedback rapidi; positivo atmosfera.

Conclusione: ai-assisted serve come strumento per aiutare gli equipaggi, non come sostituto della supervisione umana; per progettazione, questo approccio accelera selezione and assembly while remaining cohesive e confortevole per i team; la collaborazione tra registi, animatori e tecnici rimane essenziale.

Strumenti di color grading adattivi: integrazione di AI-match nelle pipeline di grading tecnico

Adotta AI-match come un plug-in dedicato, un montaggio tra formati e motore, offrendo suggerimenti di aspetto in tempo reale preservando al contempo i clip.

Obiettivo principale: ridurre i tentativi ed errori manuali permettendo alle valutazioni guidate da algoritmi di allinearsi agli aspetti di riferimento, utilizzando dati raccolti da progetti precedenti e risultati conseguiti in diversi formati.

Diverse inputs from drones and handheld cameras feed into an adaptive engine, with zoom adjustable previews and color lines analyzed across clips, ensuring emotional continuity from scene to scene.

L'integrazione lato engine crea un percorso rapido e modulare per modificare gli aspetti visivi, supporta scansioni interattive dei parametri e restituisce anteprime per le revisioni dei clienti in tempo reale, tipicamente con una latenza inferiore a 150 ms su configurazioni standard.

I progressi nell'IA supportano gli sviluppatori creando modelli che apprendono da decine di migliaia di clip (50k+), migliorando le corrispondenze e offrendo risultati coerenti in sequenza; ciò riduce le modifiche in molti lavori.

Per clienti e team, i processi diventano più interattivi, con rapide opzioni per modificare l'aspetto, impostare riferimenti e confrontare fotogrammi uno accanto all'altro; si è in grado di controllare i risultati stessi prima della consegna finale.

I formati spaziano da master 8K a clip proxy, con look consegnati allineati alle brief; droni, sport e riprese cinematografiche beneficiano tutti di una correzione colore adattiva che preserva linee e equilibrio tonale riducendo al contempo il rework.

Punteggi di confidenza basati sui fatti guidano quando applicare suggerimenti di corrispondenza AI, garantendo l'integrità del colore e minimizzando la sovrasmoothing attraverso generi, con punteggi tipici compresi tra 0,7 e 0,95 per progetti sportivi e documentaristici.

Gli sviluppatori forniscono controlli per rapidi aggiustamenti, anteprime del livello di zoom e un'integrazione abilitata per il montaggio che si allinea con i pipeline esistenti, consentendo la collaborazione in tempo reale con i clienti.

Le pratiche di valutazione sempre attive consentono ai registi di rivedere i risultati da soli, mentre i progressi dell'IA guidano tempi di consegna più rapidi, spostando l'attenzione dai compiti ripetitivi alle decisioni creative in tutti i ruoli.

Speech-to-text, sottotitoli e localizzazione: impostazione di soglie di accuratezza e passaggi di controllo qualità

Raccomandazione: definire obiettivi di accuratezza chiari per i sottotitoli e le didascalie basati su ASR, oltre a una scala di controllo qualità. Audio da studio: WER ≤ 6%, punteggiatura 95–98%, deriva temporale ≤ 0,25 s per sottotitolo; riprese sul campo: WER ≤ 8%, punteggiatura 90–95%, deriva ≤ 0,30 s. Utilizzare un algoritmo ASR, registrare correzioni rapide e regolare le soglie con i dati delle campagne. Questo strumento aiuta a mantenere un output di alta qualità in riprese diverse, affrontando se il contenuto tocca la politica o la messaggistica generale, e supporta la portata a lungo termine.

I livelli di controllo qualità (QC) combinano automazione, revisione umana e convalida della localizzazione. I controlli automatizzati analizzano i punteggi di confidenza, la lunghezza dei suggerimenti e la coerenza della punteggiatura; le fasi di QC robotiche gestiscono i controlli ripetitivi, liberando gli specialisti per concentrarsi sulle sfumature e sulle funzioni principali; la revisione umana segnala emozioni fraintese, etichette di altoparlante errate e errori di sincronizzazione; la convalida della localizzazione testa la copertura del glossario, i riferimenti culturali e la fedeltà della retrotraduzione. Programmare la verifica file per file più le revisioni batch per le campagne con più lingue.

Consigli operativi per l'integrazione: allinea le didascalie alla regola dei terzi per la leggibilità su schermi piccoli, mantieni brevi le interruzioni di riga e regola la durata per ogni indicazione per evitare sovraffollamento. Mantieni un glossario dinamico che colleghi slang, termini di marca e nomi di prodotto a trascrizioni coerenti; regola le curve del timing per il ritmo del parlato nei doppiaggi e nelle interviste per ridurre al minimo le sovrapposizioni. Utilizza l'automazione per segnalare i casi limite, ma affidati a specialisti e persone sul set per approvare i contenuti prima della pubblicazione.

Data governance e miglioramento a lungo termine: registra ogni metrica, monitora lo scostamento tra le campagne e alimenta le informazioni nelle pipeline di localizzazione a valle. Assicurati che il pubblico su smartphone o desktop riceva esperienze fluide; misura le modifiche della portata e del coinvolgimento dopo gli aggiornamenti delle didascalie. Le emozioni e il tono dovrebbero corrispondere alle immagini in modo che gli spettatori percepiscano autenticità, non una narrazione robotica. Registi, produttori, linguisti e persone sul set dovrebbero collaborare per affrontare le incomprensioni in anticipo.

| Aspetto | Metrica di destinazione | QC step | Frequenza | Proprietario |

|---|---|---|---|---|

| Accuratezza ASR | WER ≤ 6% (studio); ≤ 8% (field) | Controlli automatizzati; valutazione dell'affidabilità; verifica incrociata con la verità di riferimento | Per file | Specialisti |

| Subtitle timing | Drift ≤ 0.25 s per cue | Allineamento temporale; regolazione manuale se necessario | Per chunk | QC lead |

| Qualità della localizzazione | Glossary coverage > 85%; back-translation fidelity | Verifica del glossario; controlli di retrotraduzione | Per campagna | Team di localizzazione |

| Emozione e punteggiatura | Accuratezza della punteggiatura 95–98%; indizi emotivi allineati con gli elementi visivi | Revisione umana focalizzata sull'allineamento emotivo; etichettatura della punteggiatura | Per batch | Direttori, linguisti |

| Coerenza tra le lingue | Interruzioni di riga e formulazione coerente | QA translinguistico; test sulle didascalie dei social media | Settimanale | Ingegneri |

Asset tagging e ricerca: progettazione di schemi di metadati per media organizzati dall'IA

Adottare uno schema di metadati a livelli ancorato a campi fondamentali e a una tassonomia di tagging flessibile per ottimizzare l'organizzazione guidata dall'intelligenza artificiale e la precisione della ricerca. La struttura comprende tre livelli: metadati strutturali (asset_id, progetto), metadati descrittivi (titolo, descrizione, composizioni) e metadati amministrativi (diritti, provenienza, versione). Definire un set di termini pratico che mappi diversi contesti. Questo approccio diventa indispensabile per i team che effettuano un recupero rapido e mantengono la coerenza in una libreria di risorse. Questo approccio rende possibile allineare rapidamente i team.

I campi principali dovrebbero includere asset_id, filename, project, scene, compositions, shot_number, timecode, location, color_space, resolution, frame_rate, camera_model, lens, exposure, audio_id, licensing, access_rights.

La tassonomia dei tag deve essere bilanciata, con categorie ampie (soggetto, umore, genere) e termini granulari (oggetto, persona, azione, tecnica). Mantenere la coerenza con le convenzioni di denominazione; assicurarsi che vi sia coerenza tra le categorie ed evitare derive. Una gerarchia ben strutturata supporta un filtraggio rapido e il cross-linking tra risorse; le relazioni tra i tag aiutano a collegare scene e sequenze.

Workflow di etichettatura assistita dall'IA: passaggi iniziali tramite modelli addestrati su dati di dominio; revisione umana per correggere l'etichettatura errata; le modifiche diventano parte dell'apprendimento continuo. Utilizzare gli embedding per collegare descrizioni, composizioni e indizi visivi; abilitare la ricerca per concetto, stile o umore; possibile combinare indizi testuali con impronte digitali visive per il cross-referencing.

Interfaccia di ricerca design: supportare query booleane e in linguaggio naturale; abilitare filtri per data, posizione, argomento, composizione; includere completamento automatico e suggerimenti di tag; tracciare metriche di utilizzo per ottimizzare lo schema; monitorare pregiudizi e lacune; la tecnologia diventa un partner nella scoperta.

Governance e collaborazione tra team: stabilire la proprietà, la politica di stewardship dei metadati; assegnare data steward leader; creare convenzioni di denominazione; esistere come pratica coerente tra i team; fornire formazione; aiutare editori e produttori ad allinearsi sulla posizione e le aspettative; le relazioni tra i gruppi rafforzano la disciplina di tagging. Se stai integrando i metadati attraverso i flussi di lavoro, inizia con un progetto pilota in un singolo dipartimento.

Ottimizzazione e preparazione al futuro: progettare schemi per accogliere nuovi tipi di media; abilitare estensioni; adottare il versioning; supportare l'interoperabilità cross-platform; mirare a rimuovere tag obsoleti; garantire un track record di accuratezza a lungo termine; monitorare le prestazioni instabili nelle pipeline leggere; programmare aggiustamenti se necessario; rendere possibili aggiustamenti per formati futuri.

Risultati e focus: recupero più rapido per diversi tipi di asset; accesso più semplice alle composizioni; riutilizzo migliorato tra i progetti; i flussi di lavoro guidati dai metadati consentono originalità nelle modifiche e nella narrazione; le relazioni risultanti tra i team diventano più produttive e coerenti; resa possibile da un tagging e una ricerca disciplinati.

Controllo di qualità delle correzioni AI (stabilizzazione, upscaling, riduzione del rumore): individuazione delle tipiche modalità di errore

Inizia con un piano di QA guidato da esperimenti. Esegui un pilotaggio automatizzato su un set rappresentativo di filmati per rivelare i modi di guasto nelle fasi di stabilizzazione, upscaling e riduzione del rumore. Genera moduli concisi per i tecnici per documentare osservazioni, segnalazioni e correzioni proposte. Questo costituisce un flusso di lavoro strutturato che mantiene le aziende competitive accorciando i cicli di feedback e consentendo ai professionisti di agire rapidamente.

- Instabilità temporale: sfarfallio, sbalzi da fotogramma a fotogramma o movimento incoerente dopo la stabilizzazione che interrompe la continuità nelle sequenze.

- Artefatti di alone e bordo: aloni attorno ai bordi ad alto contrasto, anelli o bordi artificiali introdotti dallo sharpening o dall'upscaling.

- Erosione della texture: perdita di struttura fine in pelle, tessuto o opera d'arte; l'identità potrebbe svanire quando i dettagli del viso scompaiono o si spostano sottilmente.

- Sovra-smagliamento: pelle dall'aspetto plastico, texture sbavate o micro-dettagli smussati che riducono la profondità e il realismo percepiti.

- Difetti di upscaling: sfocatura delle texture, schemi a scacchiera o sbiadimenti dei colori nelle regioni ingrandite dove la risoluzione originale è insufficiente.

- Colore e deriva WB: bilanciamento del colore incoerente tra riprese o all'interno di una singola scena, che altera l'umore e la continuità.

- Inconsistenza cromatica temporale: spostamenti di colore da fotogramma a fotogramma che interrompono il ritmo visivo, soprattutto in riprese lunghe.

- Problemi di identità del viso e del corpo: disallineamento dei punti di riferimento, movimenti innaturali degli occhi o della bocca o proporzioni alterate durante l'aumento di scala o la stabilizzazione.

- Guasti nella separazione tra sfondo e primo piano: sbiadimento dei bordi tra soggetto e sfondo, causando ghosting o confini sfocati.

- Errori di interpolazione del movimento: movimento sfocato, fotogrammi fantasma o movimento accelerato che appare artificiale o innaturale.

- Rappresentazione errata della texture in condizioni di scarsa illuminazione: schemi di rumore amplificati o grana finta che stonano con il grado e l'illuminazione complessivi.

- Artefatti di logo e grafici: aliasing o posizionamento errato vicino a sovrapposizioni, titoli o terzi inferiori dopo l'elaborazione.

- Incoerenza temporale nei pattern di rumore: discrepanza della texture del rumore attraverso le transizioni di sequenza, riducendo la continuità.

Gli approcci di rilevamento per individuare i guasti ogni notte includono: diff automatiche rispetto al riferimento, SSIM e metriche percettive, e punteggi di anomalia a livello di frame. Utilizzare controlli di identità per colpo per garantire che i punti di riferimento del viso e le proporzioni del corpo rimangano stabili attraverso le correzioni e distribuire mappe di differenza per localizzare visivamente gli artefatti. Mantenere un registro sotto i moduli con timestamp, ID dello scatto e un verdetto per consentire confronti rapidi tra versioni precedenti e correnti.

- Stabilire i criteri di accettazione per ogni tipo di correzione (stabilizzazione, miglioramento della risoluzione, riduzione del rumore), concentrandosi su continuità, integrità della texture e fedeltà del colore.

- Assegnare ruoli a tecnici e operatori per i cicli di revisione; ruotare i revisori per evitare pregiudizi e ampliare la cultura del feedback.

- Esegui esperimenti ripetibili con materiale diversificato, inclusi video musicali, filmati documentari e scene ispirate all'arte, per esporre casi limite.

- Mantenere i casi organizzati per tipo di errore; generare una knowledge base che i team possano consultare prima delle successive distribuzioni.

- Sviluppare un protocollo di rapida differenziazione: se un frame devia oltre una soglia predefinita, indirizzarlo al QA manuale anziché al passaggio/fallimento automatico.

La correzione e il miglioramento dei processi si concentrano su iterazioni più rapide e sicure. Creare una pipeline standardizzata in cui le passaggi automatizzati segnalano i frame sospetti, seguiti da controlli manuali mirati. Questo approccio aiuta a distinguere le vittorie rapide dai perfezionamenti cauti, preservando l'identità e l'intento artistico, garantendo al contempo la sicurezza delle produzioni. Includere esempi da progetti di filmmaker e scenari di preservazione delle opere d'arte per illustrare come le correzioni influiscano sulla cultura, sull'identità e sulla percezione generale dell'opera.

Raccomandazioni pratiche per il miglioramento continuo:

- Integrare cicli guidati da esperimenti nelle routine quotidiane; documentare i risultati in una libreria di casi come riferimento.

- Effettuare regolarmente revisioni con un campione rappresentativo di professionisti, comprese donne, per garantire prospettive equilibrate e qualità robusta.

- Conserva backup, bobine versionate e log gestibili per proteggere la sicurezza e l'provenienza delle opere d'arte.

- Investire in formazione strutturata per tecnici e personale operativo per affinare le capacità di diagnostica e correzione.

- Allinea le correzioni con un obiettivo chiaro di conservazione dell'identità, esplorando al contempo le possibilità offerte dagli strumenti automatizzati.

L'impatto dell'IA sui video editor – Ruoli, competenze e flussi di lavoro in evoluzione" >

L'impatto dell'IA sui video editor – Ruoli, competenze e flussi di lavoro in evoluzione" >