Raccomandazione: Inizia ogni creazione di contenuti di marketing guidata dall'IA con un'analisi del rischio; integra privacy-by-design nell'intero ciclo di vita del modello; garantire che la gestione dei dati sia conforme alle normative; allinearsi ai valori del marchio.

Per affrontare pregiudizi, usi impropri, stabilire un quadro di governance; monitorare l'impatto sul pubblico attraverso le regioni; utilizzare clean dati; controlli sui rischi dell'istituto prima di pubblicare output rifiniti per una campagna.

Tuttavia, che i segnali derivano da input di prima parte o da fonti di terze parti; il process must rispettare il consenso, la trasparenza; la responsabilità rimane centrale; allinearsi con le normative globalmente; proteggere la fiducia dei consumatori; rafforzare l'integrità del marchio.

Ciò che conta per la creazione di un'impresa è la supervisione umana all'interno del ciclo; fornire spiegazioni chiare per le scelte del modello riguardanti argomenti sensibili; pubblicare riepiloghi leggeri affinché le parti interessate possano esaminarli.

Durante l'utilizzo dei dati di navigazione, mantenere le pipeline clean; mantenere una traccia verificabile; affrontare il rischio di pregiudizio; misurare l'impatto sulla percezione del marchio globalmente.

NotaQuesto framework dovrebbe essere rivisto trimestralmente; gli aggiornamenti delle policy devono riflettere le normative in evoluzione; il risultato è un lucidato governance posture che i brand possono utilizzare per definire la comunicazione, in modo responsabile.

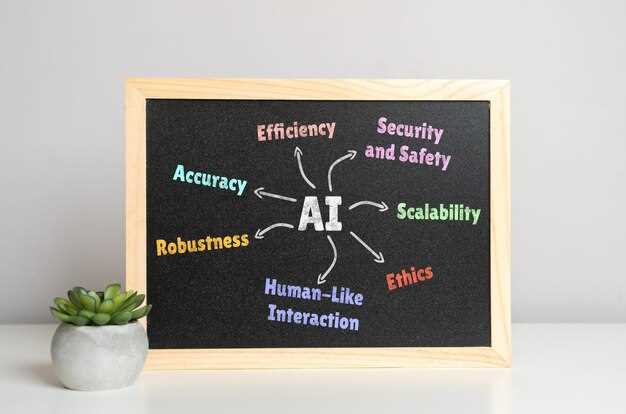

Linee guida per l'IA etica e responsabile nella pubblicità

Implementare uno schermo dei rischi prima di rilasciare qualsiasi asset automatizzato sul mercato; assegnare un proprietario multifunzionale; richiedere una firma che il piano riduca i danni a individui, gruppi; proteggere l'integrità ambientale; stabilire tempistiche di risarcimento concrete per qualsiasi guasto; allinearsi con aspettative chiaramente dichiarate in tutti i flussi di lavoro.

Verifica la provenienza dei dati; limita la dipendenza da fonti di terze parti prive di trasparenza; affidati a segnali verificabili ove possibile; implementa controlli di polarizzazione; installa protezioni; abilita il monitoraggio della deriva; richiedi una rivalutazione periodica rispetto alle pratiche del settore in evoluzione; i team possono individuare lacune tramite test automatizzati; monitora lo stato di conformità legale.

In video generation pipelines, verifica che i clip prodotti non diffondano disinformazione; evita il micro-targeting manipolativo; documenta il comportamento del modello; fornisci controlli utente; testa le rappresentazioni attraverso diverse categorie demografiche; considera le sensibilità del settore della moda; assicurati che ciò che il sistema produce soddisfi le aspettative pubblicate per l'accuratezza; verifica l'equità; implementa una rapida risoluzione dei problemi quando emergono problemi.

Governance e allineamento legale: garantire la conformità agli standard legalmente vincolanti in diverse giurisdizioni; definire flussi di lavoro chiari per il rilascio di modelli, approvazioni del rischio, audit dei fornitori; monitorare gli strumenti di terze parti per le migliori pratiche; mantenere i log di versionamento; richiedere verifiche di integrazione vermette e gpt-5; implementare la segmentazione della rete per limitare l'esposizione dei dati; stabilire percorsi di provenienza per ogni asset.

Misurazione e responsabilità: stabilire metriche per valutare le prestazioni rispetto alle aspettative; monitorare i danni, il rischio di disinformazione, la velocità; fare affidamento su audit indipendenti; fornire reportistica trasparente; consentire agli individui di richiedere correzioni; mantenere una traccia di controllo completa; adattare le valutazioni a settori come la moda; garantire che la rete soddisfi gli standard legalmente richiesti; il sistema riceve aggiornamenti in tempo reale sui principali indicatori.

Definizione di ‘Etica’ e ‘Responsabile’ nell’IA per la Pubblicità

Inizia con una politica vincolante per ogni campagna: metti in pausa le pipeline quando vengono raggiunti i livelli di rischio; documenta le decisioni; implementa delle protezioni che bloccano l'elaborazione di input sensibili.

Definisci i criteri che esistono all'interno di una collezione di algoritmi; un'istanza di disallineamento innesca una revisione; mantieni separate le regole sulla privacy dagli obiettivi creativi.

Ancorare le pratiche di dati con la provenienza; evitare fonti che violano il consenso; mantenere una raccolta di riferimenti; proteggere contro la sfocatura delle linee tra segnale e rumore; l'ambiguità simile all'acqua deve essere ridotta al minimo; fornire trasparenza di aiuto agli stakeholder.

Esegui test red-team utilizzando gpt-5 per identificare possibili scenari reali; i momenti in cui gli output diventano inaccurati devono innescare una revisione umana immediata; le iterazioni di addestramento dovrebbero colmare tali lacune.

Definire metriche raffinate richiede una governance trasparente; monitorare il comportamento del modello rispetto a un messaggio pubblicato sui limiti; fornire scenari di esempio; pensare in cicli agli aggiustamenti dell'addestramento; tuttavia, gli aggiornamenti si verificano man mano che emergono nuovi dati; i progetti dovrebbero essere misurati rispetto al rischio, con gli algoritmi calibrati di conseguenza.

Come rilevare e rimuovere i pregiudizi algoritmici nella segmentazione del pubblico

Inizia con un audit concreto: esegui il modello su un set di dati di verifica stratificato per età; geografia; dispositivo; reddito; segnala le lacune di performance nella segmentazione del pubblico; mappa i risultati alle implicazioni del mondo reale per gli utenti.

Calcola metriche come la parità demografica; le probabilità uguali; estendi con l'errore di calibrazione per sottogruppo; documenta se l'assenza di parità esiste tra cohorti correlate; mantieni un registro trasparente dei risultati.

Le distorsioni affrontate richiedono aggiustamenti all'acquisizione dei dati; selezione delle funzionalità; sogliatura; riduzione del rischio per procura rimuovendo i proxy sensibili; diversificare le fonti di raccolta dati; ripesare i segnali per i gruppi sottorappresentati; rieseguire i test per verificare l'effetto.

Mantenere la trasparenza con gli stakeholder: pubblicare una comprensione chiara del modello; condividere il messaggio di mercato senza eccessive semplificazioni; rendere evidenti i pregiudizi nelle narrazioni utilizzate dai team di campagna; mostrare quali segmenti ricevono copertura e quali ne sono esclusi. Nelle campagne reali, gli annunci pubblicitari possono mascherare i pregiudizi a meno che la trasparenza non rimanga.

Dall'ideazione all'implementazione: progettare esperimenti che testino nuove serie di funzionalità; eseguire test A/B con un'esposizione bilanciata; definire criteri di interruzione quando un divario supera le soglie predefinite.

Pratica nel mondo reale: consentire agli utenti di optare per esperienze personalizzate; possono misurare la soddisfazione; una volta rilevato un pregiudizio, assicurarsi che non vi sia manipolazione; c'è margine di miglioramento.

Mitigare il bias di velocità: misurare come funzionano in condizioni reali; l'importanza cresce con l'espansione dell'esposizione; implementare un monitoraggio continuo; distribuire dashboard leggere; rivedere a intervalli trimestrali; nel corso degli anni, si verificano scoperte quando la governance rimane rigorosa; dichiarare apertamente i risultati aumenta la fiducia.

Nota conclusiva: il vostro team dovrebbe integrare questi passaggi in un modello operativo; dare la priorità all'equità tra i segmenti; misurare l'impatto sui risultati aziendali preservando la trasparenza.

Quali dati degli utenti raccogliere, anonimizzare o evitare per la personalizzazione delle pubblicità

Raccomandazione: raccogliere solo identificatori di base essenziali per la pertinenza; anonimizzare immediatamente; mantenere i segnali hash o aggregati.

Escludere attributi sensibili come lo stato di salute, le convinzioni politiche, la razza, la religione o la posizione precisa a meno che non esista un consenso informato esplicito.

In casi come le campagne di adidas, nicole del team di analisi fa notare guadagni misurati; un approccio curato produce risultati con un rischio inferiore; i segnali dell'ultimo miglio rimangono all'interno del modello; l'utilizzo esclusivo di dati non identificabili aiuta a preservare la fiducia.

I mercati con rigide norme sulla privacy richiedono controlli più severi; limitare l'ambito dei dati fin dalla progettazione; ridurre il rischio attraverso la conservazione graduale dei dati; sapere quali segnali rimangono utili, quali si interrompono prima, quali scadono per ultimi.

Riporta al team con una chiara motivazione per ogni tipo di dato; informa gli stakeholder su come i dati si spostano dalla raccolta all'anonimizzazione; questo mantiene più forte la capacità di adattare gli algoritmi rimanendo conformi.

Ogni singolo passaggio deve essere documentato, inclusi quali dati consumano risorse, quali rimangono aggregati, quali vengono scartati; questa chiarezza supporta decisioni informate in team di mercato ampi.

Le tabelle forniscono un riferimento preciso per i casi, inclusi i mercati di grandi dimensioni; la seguente tabella delinea le categorie di dati, il trattamento e l'uso consigliato.

| Tipo di dato | Anonimizzazione / Gestione | Uso consigliato |

|---|---|---|

| Identificativi personali (email, telefono, ID utente) | Hashing, tokenizzazione, pseudonimizzazione; limitare il collegamento tra le sessioni | Supportare la pertinenza tra sessioni senza esporre l'identità; segnalare i risultati al team |

| Dati sulla posizione (GPS preciso, a livello di strada) | Aggregare a livello di città o regione; eliminare coordinate precise | Rilevanza contestuale nei mercati, soprattutto nelle campagne offline-to-online |

| Identificativi del dispositivo (IDFA/GAID) | Ruota i token, applica trasformazioni che preservano la privacy | Frequency capping, fresh exposure pacing, cohort analysis |

| Segnali di comportamento (pagine visualizzate, interazioni) | Riepiloghi aggregati basati su coorti; evitare i log grezzi | Personalizzazione all'interno di un modello rispettoso della privacy |

| Dati demografici (fascia d'età, ampi segmenti) | Segmentazione approssimativa; solo consenso esplicito, linguaggio di consenso chiaro | Personalizzazione a livello di segmento senza profilazione degli utenti singoli |

| Attributi sensibili (salute, opinioni politiche) | Eliminare a meno che non esista un consenso informato esplicito; conservare separatamente con accesso rigoroso | Solo in rari casi, con una forte giustificazione e supervisione |

| Dati di terze parti | Limita o escludi; preferisci segnali di prima parte | Ridurre il rischio; mantenere la fiducia tra i consumatori e i mercati |

| Segnali di opt-in | Mantenere chiara la provenienza; rispettare le richieste di ritiro | Personalizzazione basata su principi con controllo dell'utente |

Gli obiettivi del mercato dipendono dalla trasparenza; rendicontare le metriche in modo chiaro; informare le decisioni dell'ultimo miglio con provenienza verificabile; i team possono adattare gli algoritmi senza esporre le identità.

Come divulgare l’uso dell’IA ai consumatori senza compromettere le prestazioni delle campagne

Rivelare il coinvolgimento dell'IA in modo trasparente in tutti i contenuti rivolti ai consumatori, utilizzando una linea concisa e chiara all'inizio di ogni creazione; questo riduce la percezione errata, crea fiducia, protegge il credito ai creatori umani, responsabilizza i team.

- Frase di divulgazione chiara: “Contenuto generato con assistenza AI” o “Contenuto generato da AI”. Siate brevi; posizionatela nel primo fotogramma della pubblicità o nella didascalia del video. Affermazioni di divulgazione in linguaggio semplice riducono la percezione errata; questo approccio aiuta effettivamente gli individui a comprendere la fonte, evitando al contempo conflitti di copyright.

- Strategia di posizionamento: visibile, vicino all'intestazione; per le sovrapposizioni video, una didascalia di un secondo prima che inizi il messaggio principale; la velocità di divulgazione è importante; non c'è spazio per l'ambiguità; applicare questa divulgazione agli annunci pubblicitari per tenere informato il pubblico.

- Credito al team, ai creatori, ai team di dati: menzionare i contributori che hanno plasmato il concetto; questo delinea le responsabilità, preservando il credito ai professionisti coinvolti; la loro competenza supporta l'azienda, garantendo la continuità con i clienti.

- Copyright protection and risk management: inputs should come from licensed sources; generative outputs carry risk of violate copyright unless checked by a human reviewer; run a human review before publishing; document sources to prevent violations.

- Mitigazione dei contenuti distorti: test degli output per ritrattamenti distorti; implementare delle protezioni; utilizzare prompt diversificati, pannelli di revisione provenienti da background multipli; riduce il rischio di rappresentazioni distorte, soprattutto per campagne distribuite a livello globale.

- Localizzazione e controllo del tono: adattare le divulgazioni per regione; alcuni mercati richiedono formulazioni specifiche; mantenere la coerenza tra le campagne avviate dai team dei creatori; preservare la voce del marchio rimanendo trasparenti.

- Piano di misurazione: eseguire test controllati confrontando varianti divulgate e non divulgate; monitorare metriche come richiamo, aumento della fiducia, CTR, tasso di conversione, sentiment del marchio; adeguare i budget in base ai risultati senza sacrificare la trasparenza.

- Implementazione degli schemi: il team delinea il processo; assegnare ruoli per creativi, data scientist, legali, clienti; definire liste di controllo per garantire la conformità su tutti gli asset; l'implementazione di questo flusso di lavoro riduce il rework della velocità e del rischio.

- Comunicazione con il cliente e allineamento dei processi: presentare un piano pilota con mitigazione del rischio; affrontare le preoccupazioni relative alle prestazioni, all'esposizione legale, alla sicurezza del marchio; garantire l'allineamento prima del lancio su larga scala con i clienti.

- Sfide e miglioramento continuo: monitorare i rischi di disinformazione; creare opzioni di backup se gli output divergono dagli standard del marchio; pianificare gli aggiornamenti man mano che i modelli si evolvono; la governance rimane rigorosa; questa pratica sta diventando uno standard.

Chi è responsabile: assegnazione dell'approvazione umana e dei registri di controllo per le decisioni dell'IA

Raccomandazione: imporre una verifica umana per ogni decisione guidata dall'intelligenza artificiale che influisce sull'esposizione del pubblico; implementare registri verificabili con input, versione del modello, provenienza dei dati, timestamp, motivazione della decisione, stato di rilascio; stabilire controlli di autorizzazione prima della distribuzione per garantire la tracciabilità di tutto.

Definisci chiaramente la responsabilità: un essere umano designato che autorizza ogni implementazione; includi un revisore di riserva in caso di conflitto; conserva un ultimo firmatario più un registro delle approvazioni all'interno di un repository centralizzato per gli audit, accessibile ai team di conformità.

I tracciati di controllo (audit trails) devono catturare ambito, versione del modello, provenienza dei dati, prompt di input, indicatori di rischio, output, impatto sui consumatori; garantire archiviazione immutabile, timestamping, ruoli di accesso separati per prevenire manomissioni.

Integrare la governance attraverso i flussi di lavoro; allinearsi con campagne reali; evitare output fabbricati; includere revisioni esterne quando necessario; mantenere controlli unici per i contenuti creativi nella pubblicità.

Le metriche sono importanti per la governance; misurare le conseguenze sugli utenti, la reputazione del marchio; monitorare i risultati nel corso degli anni; prevedere i cambiamenti nel rischio; garantire cicli di apprendimento dalle campagne passate che informino le azioni future.

Adotta un artefatto di card del modello; includi informazioni sulle fonti dei dati, il regime di addestramento, i limiti; imposta controlli contro i contenuti fabbricati; mantieni flussi di conoscenza integrati in modo che i flussi di lavoro rimangano coerenti; emetti etichette di avviso per i potenziali rischi; aiuterebbe i team di consulenza a produrre valore in contesti reali.

I controlli delle autorizzazioni devono prevenire usi impropri; progettare un'approvazione dell'ultimo miglio per usi ad alto rischio; pianificare l'evoluzione della tecnologia senza compromettere la trasparenza; prepararsi a un futuro in cui le verifiche diventano di routine, non opzionali.

Assenza di approvazione invita alla deriva; un contrappunto all'automazione emerge attraverso la supervisione umana; integra la consulenza con i processi di creazione per supportare i team; mantieni la conoscenza accessibile attraverso campagne reali.

Definizione di vincoli e compromessi di equità misurabili per il targeting e le offerte

Implementare un budget di equità quantificabile per il targeting, le offerte e i limiti, in modo da garantire una deviazione minima dall'allocazione di base tra gruppi definiti; misurare quotidianamente per ogni pool di inventario, su siti web, all'interno di reti partner, tra cui agenzie e marketplace; utilizzando questo budget, i team di marketing aggiustano rapidamente le allocazioni.

Definisci una curva di compromesso tra accuratezza e equità; imposta un limite concreto sulla disparità di esposizione in punti percentuali; realoca l'inventario per segmenti che sottoperformano.

Monitorare metriche per disallineamento: mancata corrispondenza del pubblico; qualità dei clic; velocità di conversione; segnali di manipolazione; esaminare siti web, fonti di inventario, elementi visivi per potenziali inesattezze.

Proteggere i contenuti prodotti all'interno della rete: limitare immagini protette da copyright; rilevare materiale deepfake; applicare asset originali e rifiniti prodotti all'interno dei modelli partner; implementare la marcatura a filigrana.

Progettare flussi di lavoro per controlli sui rischi; chiedere se una creatività proposta introduce pregiudizi; richiedere approvazioni prima della pubblicazione; mantenere i registri di controllo.

Mappare l'inventario tra i siti web; coordinarsi con agenzie, marketplace, venditori; verificare che le risorse provengano da fonti legittime; implementare l'etichettatura dei dati per tracciare l'esposizione; proteggersi dalla disinformazione.

gpt-5; i prompt test influenzano le immagini prodotte; utilizzando altri modelli oltre a gpt-5.

Esempio: adotta un modello raffinato che includa segnali di autenticità visiva, metadati, etichettatura dell'inventario per tracciare l'esposizione; monitora le richieste per evitare etichette errate.

Cooperazione tra agenzie, editori, marketer: affrontare sfide come la disinformazione, la deriva del segnale; ridurre la disinformazione attraverso le campagne; eseguire controlli rapidi sui siti web; condividere gli apprendimenti.

valori di esempio dimostrano il livello di equità di base per le campagne su inventario, siti web.

Reporting: produrre una dashboard rifinita che mostri metriche di equità, compromessi, livelli di rischio; includere visualizzazioni, dati, tendenze.

Non esiste una singola ricetta; qualsiasi approccio sia in linea con gli obiettivi.

c'è suggerire valore in aggiornamenti incrementali ai vincoli di equità.

Utilizzo Etico e Responsabile dell’IA nella Pubblicità — Linee Guida" >

Utilizzo Etico e Responsabile dell’IA nella Pubblicità — Linee Guida" >