Start with camera-based tracking using inexpensive webcams; train a lightweight AI model that translates frames into usable poses, then retarget to a rig in blender, delivering animation quickly without wearables.

In practice, you can reach 60fps processing on 1080p streams, latency below 90–120 ms, and a median pose error under 5 cm with a pipeline that stays in-house. This information underpins expériences, blog posts, and a showcase that demonstrates platform-scale capabilities; the business case grows revenue through faster iteration, reduced hardware costs, and new service offerings to gaming and non-gaming clients alike.

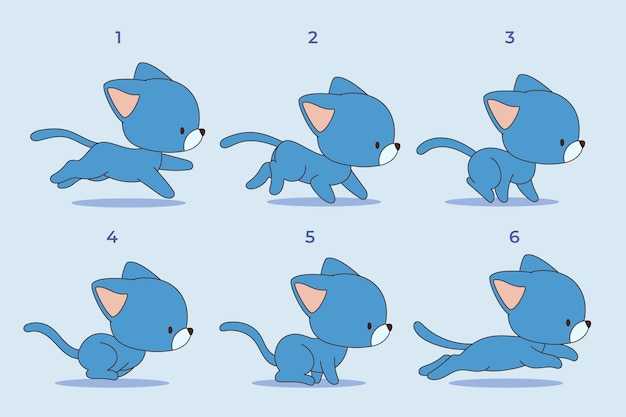

Recommended workflow: frame-by-frame estimation, apply dynamics, blend to a universal rig, bake the moves, export to a target platform, then push assets into blender, and maintain an audit trail with information that informs the team.

Adopt a modular integration so some in-house studios can evolve a shared pipeline: Python-based tooling to ingest frames, a compact trainer, and a runtime that outputs animation curves to target platform engines such as Unity, Unreal, or blender. This way, teams have a consistent framework, build information-rich experiences, and publish case studies on a blog to showcase value.

Early in-house pilots show a 2–3x reduction in iteration time, 20–40% hardware savings, and a faster ramp of creative output. The system tracks moves and dynamics with high fidelity, while experiences on the blog attract partners who value intuitive tools that feel like gaming. A crisp showcase demonstrates how a studio, with in-house talent, can scale, keep costs predictable, and deliver incredibly efficient animation workflows.

No-Suit AI Motion Capture: Practical Setup and Workflow

Install a compact, on-device pipeline with a depth camera paired to a modern GPU-laptop to achieve sub-20 ms latency and 60–120 Hz outputs. This setup yields smooth, interactive movement data directly into your digital workflow. Use a single well-aligned camera view to reduce occlusion, and calibrate once per session.

Choose devices that deliver high-quality depth, such as Azure Kinect DK or Intel RealSense, plus an optional inertial module for tricky arms. Pair with a laptop or workstation with at least 16 GB RAM and a discrete GPU (RTX 3060 or better) to keep inference stable under streaming load. If you scale to multiple characters, use a second HDMI port or USB-C dock to maintain a seamless data path, enabling leveraging multiple views to improve image fidelity. A physical reference pose improves scale accuracy, and this setup provides useful data to refine later.

Hardware is useless without a robust software stack. A lightweight AI model trained on studio data can lift cues from image streams into 3D joint positions, enabling fully digital performances. Developers can tune the network with a training set of a few thousand frames and expand using synthetic data to cover clothing, lighting, and landscapes. In practice, this gives a high level of interactive feedback for artists.

Calibrate using a standing neutral pose and a quick scaling reference. Direct streaming from the camera to the inference stage minimizes latency, with a post-filter that reduces jitter. Outputs export to your engine via a simple JSON structure that retargets to your character rig, providing image-based pose data that can be baked into animation across every asset.

This workflow supports interactive previews inside the editor, enabling you to tweak parameters live. Use a digital twin preview to adjust timing, apply smoothing, and preserve movement integrity. Streaming to the game engine should be configured for 1080p or 4K previews depending on hardware; 1080p 60 Hz is common for real-time iteration, which helps game teams iterate faster.

To ensure safety and consistency, place cameras in stable mounts, avoid occlusion zones, and set a safe desk height; implement a light background and uniform lighting to reduce false positives. Use a multi-view setup when possible to improve accuracy, which increases effectiveness in dynamic scenes like gaming demos and live-streamed events.

In practice, keep a minimal calibration routine after changing spaces. Provide a local streaming path to the engine, reducing dependency on cloud. Use color-coded feedback to indicate tracking confidence, and log frames for later analysis in training datasets to improve models. This approach delivers flexibility and thats value across diverse teams, making the system useful across every gaming scenario, landscapes, and image streams.

What makes no-suit mocap feasible today?

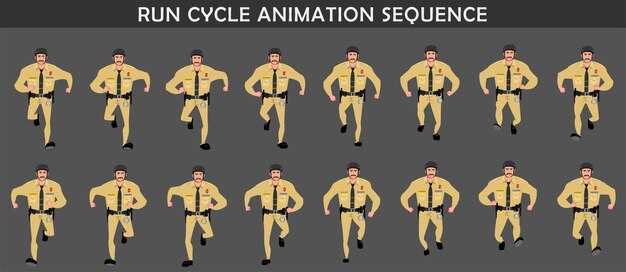

Start with a markerless tracking stack that fuses multi-view color cameras, depth sensors, and lightweight inertial units mounted on key body segments. Calculation pipelines integrate streams to produce robust 3D poses fully in real time, with latency typically under 20–40 ms on modern CPUs/GPUs. This combination relies solely on sensors rather than a full-body garment.

Behind this, the effectiveness comes from physics-based filtering, where kinematic constraints and gravity priors tighten estimates. Integrate machine learning priors with geometric optimization to maintain accuracy when occlusions occur, particularly when limbs cross or are partly hidden by the subject’s body. Credit goes to researchers behind these markerless approaches.

To cover a broad set of tasks, record diverse poses such as athletic moves, yoga postures, and everyday actions; build a pose library and use it to initialize tracking. In projects across studios, games, health apps, and simulation pipelines behind designs, you can reuse data to accelerate calibration.

Integrated hardware plus addons such as extra infrared beacons or body-worn IMUs can improve robustness; adding these is optional and enhances stability, ensuring compatibility through modular interfaces. Addons provide standardized data streams.

Health-first design guides practice: lightweight housings, even weight distribution, and breaks after short blocks to maintain comfort. simplicity in the setup supports faster onboarding and fewer errors, while quiet calibration steps keep operators focused.

Practical steps: deploy 3–4 cameras around the subject at 0.8–3 m distance; calibrate with a neutral pose; run 40–60 fps streams; apply physics-based smoothing; validate outputs on 5–10 projects to verify effectiveness.

Hardware and software you actually need (no suit)

Two to three RGB-D cameras arranged around the subject provide reliable body data for an avatar, without wearing suits. This setup directly yields capture-ready movement data you can import into Blender and other open platforms.

Lighting: three-point setup with diffused key, fill, and back lights. Target 5500–6000K color temperature and CRI above 90; keep about 500–700 lux on the subject, and avoid flicker from other light sources. This lighting improves spatial fidelity of the data.

Software workflow: Blender, an open platform, supports previs; you can retarget captured data to existing rigs; a lightweight script maps joint angles into the avatar rig.

Testing and validation: run yoga pose sequences to validate joint limits; evaluate in existing scenes; adjust scale, spacing, and timing for natural motion. Deep calibration steps refine alignment across cameras.

Hardware choices: select cameras from reliable brand families; Azure Kinect, Intel RealSense, or quality USB webcams from brands offering strong body-tracking. Ensure devices support 60–120 Hz capture and dependable drivers.

Costs and revenue: a budget kit spans a few hundred to a few thousand dollars depending on scope; open-source tooling reduces upfront cost; this path supports rapid previs in client projects, delivering creative output and revenue.

Camera placement and lighting for clean capture

Place the camera 1.0–1.2 m away, aligned with the torso midline, with the lens at 0.95–1.05 m height and a 15–20° downward tilt. Stabilize on a fixed tripod to prevent drift. In a three-camera setup, form a triangle around the subject with 0.6–0.9 m spacing between lenses and point each toward the chest center to maximize captured coverage. This baseline yields clean silhouettes in most rooms and remains robust across lighting shifts.

Lighting plan: implement a three-point system. Key light placed at 60–75° to the subject, delivering 1000–1400 lx on the face, color temperature 5400–5600 K. Use diffusion to soften shadows, with 1–2 stops of attenuation. Fill light at 30–45° opposite side, 300–500 lx, same color temperature. Backlight at 60–90° behind, 150–250 lx to separate figure from backdrop. Use a neutral background with CRI 95+ from flicker-free LEDs; avoid direct sun by masking windows when needed. This approach yields consistent, high-contrast posture lines suitable to support downstream processing. This setup provides stable, repeatable results across sessions and supports vision-based metrics with high fidelity.

Data flow: captured sessions stored in a central repository; watch recent videos from an existing blog to calibrate the posture model; export to blender-ready formats; use pre-made addons to speed calibration; through this pipeline, share outputs with clients. This enables interactive therapy sessions, facilitating industry-wide performance reviews, and offering robust workflows that run with existing hardware. The approach provides a practical path toward improving industry offerings via high-vision analytics and cross-team collaboration.

| Setup | Distance (m) | Height (m) | Tilt (deg) | Key (lx) | Fill (lx) | Back (lx) | Color (K) | Notes |

|---|---|---|---|---|---|---|---|---|

| Ligne de base unique | 1.0–1.2 | 0,95–1,05 | 15-20 | 1000–1400 | 300–500 | 150–250 | 5400–5600 | panneau diffuseur ; trépied ; accent sur la posture ; capturé avec une forte cohésion |

| Triangle à triple caméra | 1. 2–1.4 | 0,95–1,05 | 15-25 | 900–1300 | 300–500 | 150–250 | 5400–5600 | Les angles maximisent la couverture, réduisent l'occlusion, améliorent le partage de données |

| Validation des frais généraux | 2.0 | 1.60 | 0 | – | – | – | 5200 | ajoute une confirmation descendante de la posture |

De la vidéo brute aux données de mouvement utilisables : le pipeline de données

La vidéo brute transférée est mappée sur un canevas de mouvement standardisé en quelques minutes, ce qui permet une itération rapide, une intégration transparente dans les pipelines de produits et une collaboration plus facile avec les développeurs.

Utilisant l'estimation de pose pilotée par l'IA, le système détecte les points clés 2D sur chaque image et génère des données 3D grâce à un modèle de profondeur et des contraintes géométriques, fournissant ainsi les coordonnées par articulation et des métriques de confiance.

L'étalonnage aligne les espaces de coordonnées et la fréquence d'images, tandis que le nettoyage supprime les tremblements et les occlusions grâce à des techniques telles que le lissage et les contraintes basées sur la physique ; la science derrière ces étapes permet de maintenir la plausibilité biomécanique des mouvements.

Reciblez les données vers les rigs et les actifs existants, ajustez l'échelle pour correspondre aux avatars des utilisateurs et préservez l'intégration dans le pipeline de production ; conçu pour prendre en charge les flux de travail thérapeutiques avec des contrôles de sécurité.

Les contrôles de qualité suivent les résultats via l'erreur par articulation, l'écart angulaire moyen et la fréquence d'images à haute confiance ; à travers les scènes, les résultats guident les améliorations du modèle, stimulant l'engagement et les revenus.

Orientations opérationnelles : maintenir le pipeline modulaire ; permettre des mises à jour rapides par les développeurs ; réutiliser les actifs existants pour accélérer la génération de nouveau contenu ; mettre en œuvre des contrôles de confidentialité et de sécurité.

Mesurer et améliorer la qualité du mouvement : mesures et contrôles pratiques

Recommandation : commencer par une vérification de fiabilité de base utilisant des clips en prise de vues réelles collectés dans divers environnements, puis comparer les reconstructions basées sur l'IA avec les poses de référence ; calculer l'erreur quadratique moyenne (RMSE) en cm et la déviation angulaire (en degrés) pour la pose ; définir des plages cibles par articulation, acteur et scène, et itérer après les corrections.

Les indicateurs clés couvrent la précision, la fiabilité et la robustesse. Ces vérifications sont conçues pour être reproductibles sur différentes configurations, outils et équipes, aidant ainsi quiconque travaillant sur un projet à améliorer la qualité sans matériel supplémentaire.

- Précision et fidélité de la pose

- Précision de la pose : indiquer l’erreur quadratique moyenne (RMSE) des positions des articulations en centimètres ; les plages cibles varient selon la longueur des membres, les poignets et les chevilles se situant généralement dans la bande des 2 à 5 cm, les genoux et les coudes entre 3 et 6 cm, et les hanches entre 4 et 8 cm sur des données bien calibrées.

- Précision des angles articulaires : documenter l’erreur absolue moyenne en degrés pour les principales articulations (épaule, coude, hanche, genou, cheville) ; viser une erreur de 3 à 6 degrés dans des conditions d’éclairage modéré et des scènes standard.

- Couverture des poses : assurer une répartition dense des poses capturées dans les différentes actions (debout, marche, accroupissement, flexion) afin d'éviter les angles morts dans le modèle.

- Alignement de la vérité terrain : utiliser une courte séquence en prise de vues réelles avec des points de repère de référence afin de vérifier l’alignement entre le squelette reconstitué et la silhouette visible ; indiquer l’erreur de reprojection en pixels pour les images clés.

- Stabilité temporelle et dérive

- Cohérence d'une image à l'autre : mesurer le delta de pose moyen (distance entre les images consécutives) et limiter la dérive à moins de 1,5 à 3 cm par seconde en fonction de l'activité.

- Dérive sur les clips : suivre la déviation cumulative sur une période de 10 à 30 secondes ; cibler une dérive totale de moins de 5 cm pour les actions typiques, avec des limites plus strictes pour les séquences rapides.

- Latence d'animation : quantifier le délai entre le mouvement réel et la pose reconstituée, en privilégiant un délai inférieur à 100 ms pour que la synchronisation reste crédible dans les aperçus en direct.

- Robustesse entre les configurations

- Résilience à l'éclairage : comparer les mesures de précision sous trois scénarios d'éclairage (fort, moyen, faible) ; s'assurer que les changements restent dans une fourchette de ±20 % des erreurs de base.

- Complexité de l'arrière-plan : tester sur des scènes avec encombrement ou arrière-plan en mouvement ; signaler la chute de visibilité des points clés et les changements de précision correspondants.

- Impact de la fusion de capteurs : lors de l’ajout d’indices externes (par exemple, profondeur, indices inertiels), quantifier les gains en termes de stabilité et de précision ; documenter les rendements décroissants au-delà d’un certain seuil.

- Qualité des données et indicateurs de santé

- Taux de données manquantes : suivre les images avec des points clés occlus ou non détectés ; maintenir un taux inférieur à 2–5 % dans des environnements contrôlés, des seuils plus élevés étant acceptables dans des scènes difficiles.

- Seuil de bruit : surveiller la gigue dans les régions à faible contraste ; n’appliquer le lissage qu’après avoir confirmé un véritable plancher d’erreurs plutôt que de filtrer les détails utiles.

- Santé des capteurs et des outils : enregistrer l'état de l'étalonnage, la fréquence d'images et la charge de traitement ; alerter lorsque l'une de ces mesures tombe en dessous des objectifs de fiabilité prédéfinis.

- Alignement physiologique et contrôles de réalisme

- Indices de santé et de mobilité : vérifier que les longueurs des membres et les limites des articulations restent dans des plages humaines plausibles ; signaler les poses anatomiquement invraisemblables pour une inspection manuelle.

- Proxies de cohérence des forces : comparer les forces articulaires inférées ou la plausibilité du contact avec les schémas d'activité connus ; mettre en évidence les scènes où les estimations de force semblent incompatibles avec le mouvement.

- Workflow de validation et commentaires

- Appariement de la vérité terrain : créer un ensemble de validation léger à l’aide de clips d’action réelle avec des références de vérité terrain claires ; mettre à jour les seuils après chaque série de 5 à 10 projets.

- Boucle de rétroaction de l'équipe : recueillir des notes détaillées des animateurs et des TDs (techniciens) après les revues ; regrouper les problèmes par type (occlusion, mouvement rapide, poses inhabituelles) pour orienter les améliorations ciblées.

- Cadence d'itération : exécutez un cycle court chaque semaine, en vous concentrant d'abord sur les principaux modes de défaillance ; documentez les améliorations et les lacunes restantes dans une liste de contrôle évolutive.

- Vérifications pratiques par scène et par acteur

- Variété des scènes : inclure des actions telles que marcher, sauter, se pencher et grimper ; suivre si la précision est maintenue lors des transitions entre les actions.

- Diversité des acteurs : testez avec des interprètes de différentes tailles, morphologies et niveaux de mobilité ; ajustez les modèles pour réduire les biais dans le placement des points de repère et l’interprétation de la pose.

- Tableaux de bord entièrement automatisés : implémenter des tableaux de bord affichant les métriques par scène, les tendances par acteur et l’état de santé de la configuration ; permettre à tous les membres de l’équipe de repérer rapidement les régressions.

- Conseils de processus et de mise en œuvre

- Revue après session : organisez de brefs débriefings pour comparer les résultats numériques avec le feedback visuel des prévisualisations basées sur la vision et les références d’action réelle.

- Documentation : tenir un registre détaillé des configurations, des versions d'outils et des étapes d'étalonnage afin que les équipes travaillant sur un projet puissent reproduire les résultats.

- Flexibilité : concevez des vérifications pour tenir compte des nouvelles scènes, des équipements ou des ensembles de données ; préservez un cadre évolutif qui grandit avec vos flux de travail basés sur l’IA.

- Seuils exploitables : définissez des critères concrets de réussite/échec pour chaque métrique ; évitez les objectifs vagues afin de rendre l’ajustement ciblé et mesurable.

Éléments de soutien : assurer une visibilité claire des scènes, des poses et du timing ; fournir des commentaires exploitables aux monteurs et aux animateurs via des notes concises et des traces numériques ; maintenir un flux de travail sain autour de la qualité des données, de l'étalonnage et des mises à jour des modèles ; grâce à cette approche structurée, tous les intervenants bénéficient d'un chemin fiable et transparent vers un réalisme amélioré et un mouvement crédible sans instrumentation lourde.

Simple AI Motion Capture – Pas besoin de combinaison pour des animations réalistes" >

Simple AI Motion Capture – Pas besoin de combinaison pour des animations réalistes" >