Recommandation : Commencez chaque création de contenu marketing pilotée par l'IA par un audit des risques ; intégrez privacy-by-design dans le cycle de vie du modèle ; garantir que la gestion des données est conforme à la réglementation ; s’aligner sur les valeurs de la marque.

Pour lutter contre les biais, les utilisations abusives, établir un cadre de gouvernance ; surveiller l'impact sur les audiences à travers les régions ; utiliser clean data ; institute risk controls before publishing polished outputs for a campaign.

Cependant, whether les signaux proviennent d'entrées en provenance directe ou de sources tierces ; le process doit respecter le consentement, la transparence ; la responsabilisation reste centrale ; s’aligner sur les réglementations. globalement; protéger la confiance des consommateurs ; stimuler l'intégrité de la marque.

Ce qui compte pour la création d'entreprise, c'est la supervision humaine au sein de la boucle ; fournir des explications claires pour les choix de modèles concernant des sujets sensibles ; publier des résumés légers pour que les parties prenantes puissent les examiner.

Pendant l'utilisation des données de navigation, maintenez les pipelines. clean; maintenir une piste d'audit ; traiter le risque de biais ; mesurer l'impact sur la perception de la marque globalement.

Note: Ce cadre devrait être revu trimestriellement ; les mises à jour des politiques doivent refléter l'évolution des réglementations ; le résultat est un poli une posture de gouvernance sur laquelle les marques peuvent s'appuyer pour façonner le message, de manière responsable.

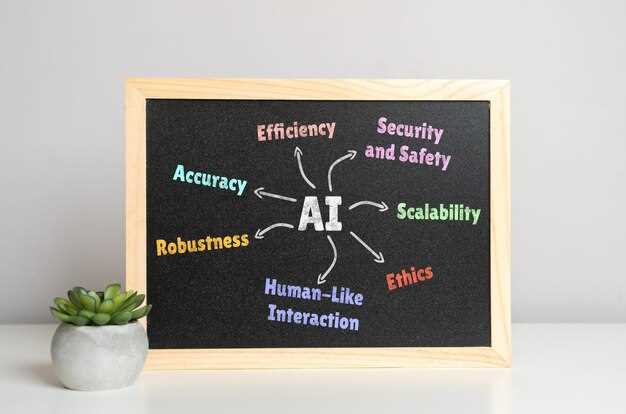

Lignes directrices pour une IA éthique et responsable dans la publicité

Déployez un écran de risque avant de lancer tout actif automatisé sur le marché ; désignez un responsable interfonctionnel ; exigez une approbation attestant que le plan réduit les dommages aux individus, aux groupes ; protégez l'intégrité environnementale ; fixez des délais de remédiation concrets pour toute défaillance ; alignez-vous sur des attentes clairement définies à travers les flux de travail.

Audit de la traçabilité des données ; limiter la dépendance à l'égard de sources tierces manquant de transparence ; s’appuyer sur des signaux vérifiables chaque fois que possible ; mettre en œuvre des contrôles de biais ; installer des garde-fous ; activer la surveillance de la dérive ; exiger une révalidation périodique par rapport aux pratiques de l'industrie en évolution ; les équipes peuvent identifier les lacunes grâce à des tests automatisés ; suivre le statut de conformité légale.

Dans les pipelines de génération de vidéos, vérifiez que les clips produits ne diffusent pas de désinformation ; évitez le micro-ciblage manipulateur ; documentez le comportement du modèle ; fournissez des contrôles utilisateur ; testez les représentations à travers les données démographiques ; tenez compte des sensibilités de l'industrie de la mode ; assurez-vous que ce que le système produit répond aux attentes publiées en matière de précision ; vérifiez l'équité ; mettez en œuvre une résolution rapide des problèmes en cas de problèmes.

Gouvernance et alignement juridique : garantir la conformité aux normes juridiquement contraignantes dans toutes les juridictions ; définir des flux de travail clairs pour la publication des modèles, les approbations des risques, les audits des fournisseurs ; surveiller les outils tiers pour les meilleures pratiques ; maintenir des journaux de versionnement ; exiger des vérifications d'intégration vermette et gpt-5 ; mettre en œuvre une segmentation réseau pour limiter l'exposition des données ; établir des pistes de provenance pour chaque actif.

Mesure et responsabilisation : définir des indicateurs pour évaluer la performance par rapport aux attentes ; surveiller les dommages, le risque de désinformation, la rapidité ; s'appuyer sur des audits indépendants ; fournir des rapports transparents ; permettre aux individus de demander des corrections ; maintenir une piste d'audit complète ; adapter les évaluations aux secteurs comme la mode ; s'assurer que le réseau respecte les normes légales requises ; le système reçoit des mises à jour en temps réel sur les indicateurs clés.

Définir l'éthique et la responsabilité de l'IA dans la publicité

Commencer par une politique contraignante pour chaque campagne : suspendre les pipelines lorsque les seuils de risque sont atteints ; documenter les décisions ; mettre en œuvre des protections qui bloquent le traitement des entrées sensibles.

Définir les critères qui existent dans une collection d'algorithmes ; une instance de mauvais alignement déclenche un examen ; conserver les règles de confidentialité distinctes des objectifs créatifs.

Ancrer les pratiques de données avec la traçabilité ; éviter les sources qui violent le consentement ; maintenir une collection de références ; se prémunir contre le flou entre le signal et le bruit ; l'ambiguïté semblable à l'eau doit être minimisée ; fournir une transparence utile aux parties prenantes.

Effectuer des tests red-team avec gpt-5 pour identifier des scénarios du monde réel probables ; les moments où les résultats deviennent inexacts doivent déclencher une revue humaine immédiate ; les itérations de formation doivent combler ces lacunes.

Définir des métriques abouties exige une gouvernance transparente ; suivre le comportement du modèle par rapport à un message publié concernant les limites ; fournir des scénarios d'exemple ; penser en cycles aux ajustements de formation ; cependant, les mises à jour surviennent lorsque de nouvelles données existent ; les conceptions doivent être mesurées par rapport au risque, les algorithmes étant calibrés en conséquence.

Comment détecter et supprimer les biais algorithmiques dans la segmentation de l’audience

Commencez par un audit concret : exécutez le modèle sur un ensemble de validation séparé, stratifié par âge ; géographie ; appareil ; revenu ; signalez les écarts de performance dans la segmentation de l'audience ; faites correspondre les résultats aux implications concrètes pour les utilisateurs.

Calculer des métriques telles que la parité démographique ; les chances égales ; étendre avec l'erreur d'étalonnage par sous-groupe ; documenter si l'absence de parité existe à travers des cohortes liées ; maintenir un journal transparent des résultats.

Les biais corrigés nécessitent des ajustements à l'entrée des données ; la sélection des caractéristiques ; le seuillage ; réduire le risque de proxy en supprimant les proxies sensibles ; diversifier les sources de collecte de données ; pondérer à nouveau les signaux pour les groupes sous-représentés ; relancer les tests pour vérifier l'effet.

Maintenir la transparence avec les parties prenantes : publier une compréhension concise du modèle ; partager le message du marché sans simplification excessive ; révéler les biais dans les récits utilisés par les équipes de campagne ; montrer quels segments reçoivent une couverture, lesquels en sont exclus. Dans les campagnes du monde réel, les publicités peuvent masquer les biais à moins que la transparence ne soit maintenue.

De l'idéation à la mise en œuvre : concevoir des expériences qui testent de nouveaux ensembles de fonctionnalités ; effectuer des tests A/B avec une exposition équilibrée ; définir des critères d'arrêt lorsque l'écart dépasse des seuils prédéfinis.

Pratique concrète : permettre aux utilisateurs de s’inscrire à des expériences personnalisées ; ils peuvent mesurer la satisfaction ; une fois les biais détectés, s’assurer de l’absence de manipulation ; il y a place pour l’amélioration.

Atténuer les biais de vitesse : mesurer leur fonctionnement dans des conditions réelles ; l'importance augmente à mesure que l'exposition s'étend; mettre en œuvre une surveillance continue; déployer des tableaux de bord légers ; examiner tous les trimestres ; au fil des ans, des percées se produisent lorsque la gouvernance reste stricte ; communiquer ouvertement les résultats renforce la confiance.

Remarque de clotüre : votre équipe doit intégrer ces étapes dans un modèle d'activité ; accorder la priorité à l'équitable entre les segments ; mesurer l'impact sur les résultats commerciaux tout en assurant la transparence.

Quelles données utilisateur collecter, anonymiser ou éviter pour la personnalisation des publicités

Recommandation : ne collecter que les identifiants de base essentiels pour la pertinence ; anonymiser immédiatement ; conserver les signaux hachés ou agrégés.

Exclure les attributs sensibles tels que l'état de santé, les convictions politiques, la race, la religion ou la localisation précise, sauf s'il existe un consentement éclairé explicite.

Dans des cas comme les campagnes adidas, Nicole de l'équipe d'analyse note des gains mesurables ; une approche soignée donne des résultats avec un risque plus faible ; les signaux du dernier kilomètre restent dans le modèle ; l'utilisation uniquement de données non identifiables aide à préserver la confiance.

Les marchés dotés de règles strictes en matière de confidentialité exigent des contrôles plus stricts ; limiter la portée des données dès la conception ; réduire les risques par le biais d'une conservation progressive des données ; savoir quels signaux restent utiles, lesquels s'arrêtent plus tôt, lesquels expirent en dernier.

Faites un compte rendu à l'équipe avec une justification claire pour chaque type de données ; informez les parties prenantes de la façon dont les données transitent de la collecte à l'anonymisation ; cela permet de maintenir une capacité d'adaptation des algorithmes tout en restant conforme.

Chaque étape doit être documentée, y compris les données qui consomment des ressources, celles qui restent agrégées, celles qui sont rejetées ; cette clarté soutient les décisions éclairées au sein de grandes équipes sur le marché.

Les tableaux fournissent une référence soignée pour les cas, y compris les grands marchés ; le tableau suivant décrit les catégories de données, le traitement et l'utilisation recommandée.

| Type de données | Anonymisation / Gestion | Utilisation recommandée |

|---|---|---|

| Identifiants personnels (adresses courriel, numéros de téléphone, identifiants utilisateurs) | Hachage, tokenisation, pseudonymisation ; restreindre les liens entre les sessions | Prendre en charge la pertinence inter-sessions sans exposer l'identité ; signaler les résultats à l'équipe. |

| Données de localisation (GPS précises, au niveau de la rue) | Agréger au niveau de la ville ou de la région ; supprimer les coordonnées précises | Pertinence contextuelle dans les marchés, en particulier dans les campagnes de transition hors ligne vers en ligne |

| Identifiants d'appareil (IDFA/GAID) | Faire pivoter les jetons, appliquer des transformations préservant la vie privée | Limitation de fréquence, rythme d'exposition actualisée, analyse de cohortes |

| Signaux de comportement (pages vues, interactions) | Synthèses agrégées et basées sur des cohortes ; éviter les journaux bruts. | Personnalisation dans un modèle respectueux de la vie privée |

| Données démographiques (tranche d'âge, segments larges) | Segmentation grossière ; opt-in uniquement, langage clair concernant le consentement. | Personnalisation au niveau du segment sans profilage des utilisateurs individuels |

| Attributs sensibles (santé, opinions politiques) | Supprimer, sauf consentement éclairé explicite ; stocker séparément avec un accès strict | Uniquement dans de rares cas, avec une justification et une supervision solides. |

| Données tierces | Limiter ou exclure ; privilégier les signaux first-party | Réduire les risques ; maintenir la confiance des consommateurs et des marchés |

| Opt-in signals | Garder la provenance claire ; respecter les demandes de retrait. | Personnalisation éthique avec contrôle utilisateur |

Les objectifs du marché dépendent de la transparence ; indiquez clairement les mesures ; informez les décisions du dernier kilomètre de données d'origine vérifiables ; les équipes peuvent adapter les algorithmes sans exposer les identités.

Comment divulguer l'utilisation de l'IA aux consommateurs sans nuire aux performances des campagnes

Divulguez clairement l'implication de l'IA au début de tout contenu destiné aux consommateurs, en utilisant une ligne concise et claire au début de chaque création ; cela réduit les idées fausses, renforce la confiance, protège les droits des créateurs humains et autonomise les équipes.

- Phrase de divulgation claire : « Contenu généré avec l'aide de l'IA » ou « Contenu généré par l'IA ». Gardez-la courte ; placez-la dans la première image de la publicité ou de la légende vidéo. L'utilisation d'un langage clair pour ces divulgations réduit la méprise ; cette approche aide en réalité les individus à comprendre la source, tout en évitant les conflits de droits d'auteur.

- Stratégie de placement : visible, près du titre ; pour les superpositions vidéo, un sous-titre d'une seconde avant le début du message principal ; la rapidité de la divulgation est importante ; il n'y a pas de place pour l'ambiguïté ; appliquez cette divulgation aux publicités afin de tenir les audiences informées.

- Crédit à l'équipe, aux créateurs, aux équipes de données : mentionner les contributeurs qui ont façonné le concept ; cela décrit les responsabilités, préserve le crédit accordé aux professionnels impliqués ; leur expertise soutient l'entreprise, garantissant la continuité avec les clients.

- Protection du droit d'auteur et gestion des risques : les données doivent provenir de sources agréées ; les résultats générés comportent un risque de violation du droit d'auteur sauf vérification par un examinateur humain ; effectuer un examen humain avant publication ; documenter les sources pour prévenir les violations.

- Atténuation du contenu biaisé : tester les résultats pour identifier les représentations biaisées ; mettre en place des garde-fous ; utiliser des invites diversifiées, des panels de révision issus de multiples horizons ; cela réduit le risque de représentations biaisées, en particulier pour les campagnes distribuées à l'échelle mondiale.

- Localisation et contrôle du ton : adapter les divulgations par région ; certains marchés exigent des formulations spécifiques ; maintenir la cohérence entre les campagnes lancées par les équipes de créateurs ; préserver la voix de la marque tout en restant transparent.

- Plan de mesure : mener des tests contrôlés comparant les variantes divulguées et non divulguées ; suivre des indicateurs tels que le rappel, l'augmentation de la confiance, le CTR, le taux de conversion, le sentiment de la marque ; ajuster les budgets en fonction des résultats sans sacrifier la transparence.

- Implementation outlines: l'équipe décrit le processus ; attribuer des rôles aux créatifs, aux data scientists, aux juristes, aux clients ; définir des listes de contrôle pour assurer la conformité de l'ensemble des actifs ; la mise en œuvre de ce flux de travail réduit les reprises et les risques.

- Communication avec les clients et alignement des processus : présenter un plan pilote avec atténuation des risques ; répondre aux préoccupations concernant la performance, l'exposition juridique, la sécurité de la marque ; garantir l'alignement avant un déploiement à grande échelle auprès des clients.

- Défis et amélioration continue : surveiller les risques liés à la désinformation ; élaborer des options de secours si les résultats s'écartent des normes de la marque ; planifier des mises à jour à mesure que les modèles évoluent ; la gouvernance reste stricte ; cette pratique est en train de devenir une norme.

Qui est responsable : attribution d'une validation humaine et de pistes d'audit pour les décisions de l'IA

Recommandation : imposer une validation humaine pour chaque décision pilotée par l'IA qui affecte l'exposition de l'audience ; mettre en œuvre des journaux d'audit avec les entrées, la version du modèle, la provenance des données, les horodatages, le raisonnement de la décision, le statut de publication ; établir des passerelles d'autorisation avant le déploiement afin de garantir la traçabilité de tout.

Définir clairement la responsabilité : un responsable humain désigné autorisant chaque déploiement ; inclure un examinateur de secours si un conflit survient ; conserver un dernier signataire ainsi qu'un journal des approbations dans un référentiel centralisé pour les audits, accessible aux équipes de conformité.

Les pistes d'audit doivent capturer la portée, la version du modèle, la lignée des données, les invites d'entrée, les indicateurs de risque, les résultats, l'impact sur les consommateurs ; garantir un stockage immuable, l'horodatage, des rôles d'accès distincts pour empêcher toute falsification.

Intégrer la gouvernance à travers les flux de travail ; aligner avec les campagnes du monde réel ; éviter les résultats fabriqués ; inclure des examens externes lorsque cela est nécessaire ; maintenir des vérifications uniques pour le contenu créatif en publicité.

Les indicateurs sont importants pour la gouvernance ; mesurer les conséquences sur les publics, la réputation de la marque ; suivre les résultats sur plusieurs années ; prédire les changements de risque ; garantir des boucles d'apprentissage à partir des campagnes passées afin d'éclairer les actions futures.

Adopter un artefact de carte de modèle ; inclure des informations sur les sources de données, le régime d'apprentissage, les limites ; définir des contrôles contre le contenu fabriqué ; maintenir des flux de connaissances intégrés afin que les flux de travail restent cohérents ; publier des étiquettes d'avertissement pour les risques potentiels ; aiderait les équipes à produire de la valeur dans des contextes du monde réel.

Les contrôles d'autorisation doivent empêcher les utilisations abusives ; concevez une approbation du dernier kilomètre pour les utilisations à haut risque ; prévoyez l’évolution de la technologie sans compromettre la transparence ; préparez-vous à un avenir où les audits deviendront une routine, et non une option.

L'absence de validation invite à la dérive ; un contrepoint à l'automatisation émerge grâce à la supervision humaine ; intégrez les conseils aux processus de création pour soutenir les équipes ; maintenez les connaissances accessibles à travers les campagnes concrètes.

Définir des contraintes et des compromis de fairness mesurables pour le ciblage et les enchères

Mettre en œuvre un budget de fairness quantifiable pour le ciblage, les enchères et le capping, en assurant un écart par rapport à une allocation de référence entre des groupes définis ; mesurer quotidiennement par pool d'inventaire, sur les sites web, au sein des réseaux de partenaires y compris les agences, les marketplaces ; en utilisant ce budget, les équipes marketing ajustent rapidement les allocations.

Définir une courbe de compromis d'équité qui fait correspondre la précision à l'équité ; fixer une limite concrète sur le déséquilibre de l'exposition en points de pourcentage ; réaffecter les stocks pour les segments qui sous-performent.

Surveiller les métriques de désalignement : inadéquation du public ; qualité des clics ; vélocité de conversion ; signaux de manipulation ; examiner les sites Web, les sources d'inventaire, les visuels pour détecter d'éventuelles erreurs de représentation.

Protéger le contenu produit au sein du réseau : restreindre les visuels protégés par le droit d'auteur ; détecter le matériel deepfake ; faire respecter les éléments graphiques originaux et soignés produits dans les modèles partenaires ; mettre en œuvre le watermarking.

Concevoir des flux de travail pour les vérifications des risques ; demander si une création proposée introduit un biais ; exiger des approbations avant le déploiement en direct ; tenir des journaux d'audit.

Cartographier l'inventaire sur les sites web ; coordonner avec les agences, les places de marché, les vendeurs ; vérifier que les actifs proviennent de sources légitimes ; mettre en œuvre l'étiquetage des données pour retracer l'exposition ; se prémunir contre la désinformation.

gpt-5 ; les invites de test influencent les visuels produits ; utiliser d'autres modèles que gpt-5.

Adoptez un modèle peaufiné qui inclut des signaux d'authenticité visuelle, des métadonnées, un marquage des stocks pour retracer l'exposition ; surveillez les invites pour éviter les étiquettes erronées.

Coopération entre les agences, les éditeurs, les marketeurs : répondre aux défis tels que la désinformation, la dérive du signal ; réduire la désinformation à travers les campagnes ; effectuer des vérifications rapides sur les sites web ; partager les enseignements.

les valeurs d'exemple illustrent le niveau de base d'équité pour les campagnes sur l'inventaire, les sites web.

Reporting : produire un tableau de bord abouti présentant des indicateurs d'équité, des compromis, des niveaux de risque ; inclure des visuels, des données, des tendances.

Il n'existe pas de recette unique ; quelle que soit l'approche qui correspond aux objectifs.

il y a une valeur suggérée dans les mises à jour incrémentales des contraintes d'équité.

Utilisation éthique et responsable de l'IA dans la publicité — Directives" >

Utilisation éthique et responsable de l'IA dans la publicité — Directives" >