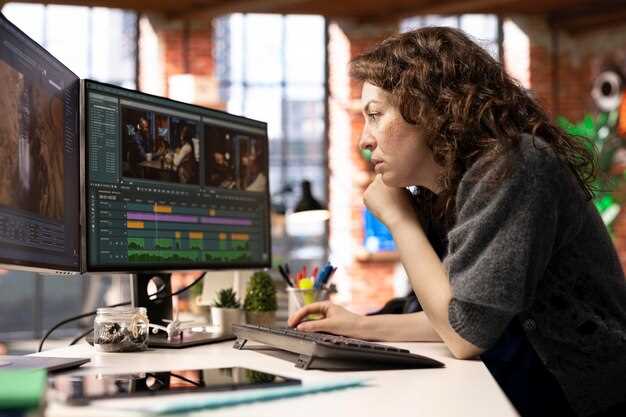

Recomendaciónintegrar herramientas aceleradas por IA para automatizar tareas repetitivas, permitiendo que los profesionales dediquen gran parte de su tiempo a la narración visual que conecte con el público. definitivamente viable para equipos que tradicionalmente dependían del pulido manual, mientras se mantiene el enfoque en la calidad esencial y se cumplen los plazos de entrega ajustados.

La IA remodela las tareas dentro de la postproducción al trasladar la corrección de color rutinaria, el etiquetado de activos y las decisiones de corte rudo a bucles automatizados. Este artículo destaca cómo construir rastros de auditoría transparentes y verificaciones con humanos en el circuito durante las pruebas piloto para garantizar la sensibilidad al tono y los matices a pesar de las limitaciones; esto minimiza la deriva entre escenas. Regular reuniones con la ayuda de clientes y partes interesadas navegar expectativas y acortar los ciclos del brief a la entrega.

Para profesionales que buscan mejorar sus habilidades, cuatro pasos prácticos: (1) crear una biblioteca de preajustes asistidos por IA para color, estabilización, generación de subtítulos y animación; (2) alinear el crecimiento de habilidades alrededor animación y diseño de sonido para respaldar cortes automatizados; (3) definir esencial métricas para juzgar la calidad de la salida más allá de la velocidad; (4) ejecutar reuniones con clientes para alinear expectativas. Este enfoque tradicionalmente fits business necesidades mientras se preserva la intención creativa.

En este artículo, los pilotos tempranos muestran ganancias: enorme reducciones en el tiempo hasta el primer corte y una mayor coherencia en los metadatos. En la práctica, el etiquetado asistido por IA y las sugerencias de precalificación pueden reducir las iteraciones por mucho y mejorar la colaboración con audiencias. La sensibilidad to narrative arc is vital; los humanos deben revisar los fotogramas críticos, especialmente en escenas de conflicto. Al planificar, prueba en un proyecto representativo para medir el impacto e iterar.

Consideraciones para la adopción incluyen el riesgo de desviación creativa, gobernanza de datos, licencias para activos generados y alineación con los plazos del cliente. Establezca una propiedad clara para los resultados de la IA y establezca salvaguardias para el color, el ritmo y el diseño de sonido. En la práctica, mantenga un equipo ligero producción pipeline y reuniones con las partes interesadas para calibrar el progreso; este enfoque ayuda a los equipos navegar expectations y entregar valor a los clientes al tiempo que se amplía el alcance con el público.

Cambios Concretos en las Responsabilidades y Tareas Diarias del Editor

Establecer un ciclo de edición modular que se basa en preajustes de movimiento y activos de stock para reducir drásticamente las ediciones rutinarias, impulsando los proyectos hacia los hitos de entrega fácilmente.

Crear una biblioteca centralizada compartida por equipos colaboradores, permitiendo que miles de clips sean seleccionados con un mínimo de fricción mientras los videógrafos suministran material en el sitio.

Desmonta las líneas de tiempo tradicionales combinando elementos de creación de forma dinámica, permitiendo que las opciones de color y las secuencias de movimiento se vuelvan a ensamblar en segundos.

Abordar el cambio de responsabilidad definiendo pasos que requieran colaboración con los especialistas en marketing para garantizar que el inventario y los activos creados aborden los objetivos de la campaña.

Las decisiones de corte repetitivas descartadas dan paso a elecciones basadas en datos; una lista de indicadores de análisis guía a este equipo hacia resultados más rápidos y consistentes.

Los ejemplos de proyectos destacan cómo miles de actores perciben el movimiento, los colores y el ritmo; comprender los estados de ánimo del público da forma a una danza entre cortes, lo que ayuda a los videógrafos y los especialistas en marketing a alinear sus objetivos en una sola visión.

la revolución avanza, interrumpe los procesos tradicionales, requiriendo una cuidadosa selección y escuchar los comentarios de los colaboradores; esta realidad impulsa a miles de creadores a adaptarse.

Registro automatizado y selección de fragmentos: configuración de preajustes y revisión de selecciones de IA

Configure presets para autologrear metadatos esenciales para cada clip, incluyendo tipo de plano, ubicación, tomas y duración; asigna una puntuación de confianza a las selecciones de IA y realiza una prueba para calibrar la precisión.

En flujos de trabajo previsibles, este enfoque reduce el etiquetado manual y acelera la revisión, ofreciendo selecciones de alta calidad que se alinean con los objetivos narrativos.

- Presets por concepto: categoriza tomas como escena, entrevista, acción, gráfico o b-roll; captura campos como lente, velocidad de fotogramas, exposición, balance de blancos y espacio de color.

- La IA elige la puntuación: adjunte un valor de confianza y una etiqueta de motivo (por ejemplo, “arco narrativo sólido” o “énfasis visual”), permitiendo a los revisores juzgar de un vistazo.

- Acceso a la biblioteca: almacenar los clips coincidentes en una biblioteca centralizada; combinado con la integración de sora, los analistas pueden comparar referencias de planos y tendencias similares.

La mejor práctica implica refinar los preajustes después de una prueba. La revisión asistida por IA demuestra ahorros de costes y reducción de tiempo, a la vez que proporciona asistencia a los especialistas.

Ajustar un conjunto preestablecido es sencillo: modifica las categorías, cambia los campos de etiquetado y vuelve a ejecutar una pequeña muestra; los resultados proporcionan orientación sobre la cantidad de planos y la alineación con el guion o el guion gráfico.

Al revisar las selecciones de IA, concéntrate en una narrativa concisa: conserva los planos que contribuyen a la trama, elimina las tomas redundantes y preserva las transiciones; utiliza superposiciones gráficas para marcar las selecciones y exporta una lista corta para decisiones de color en el set o internas.

Consejos prácticos para el flujo de trabajo:

- Activar el registro automático para cada clip durante la captura para construir una base de datos en constante crecimiento.

- Realice un cribado con asistencia de IA con una pasada separada para filtrar por estado de ánimo, tempo y ritmo.

- Anota las decisiones en un campo de notas compartido para respaldar futuras sesiones y la colaboración con los equipos de acceso.

- Evalúe los resultados con una prueba rápida utilizando una pequeña bobina; mida el tiempo ahorrado y el valor añadido, no solo la cantidad.

Los resultados incluyen una reducción del trabajo manual, una preparación más rápida y una biblioteca que respalda las tendencias y la búsqueda para proyectos futuros; la rentabilidad mejora a medida que el dinero ahorrado se capitaliza durante el período posterior.

Este enfoque demuestra cómo los jugadores de alto nivel pueden combinar la puntuación impulsada por OpenAI con una estética vanguardista; el tono y el ritmo guían las selecciones al tiempo que mantienen un equilibrio agradable entre variedad y cohesión. También ofrece un camino claro para los equipos que optimizan el valor y el acceso entre departamentos.

Para equipos especializados en narración de historias concisa y basada en datos, combinar preajustes con selecciones de IA ofrece una vía escalable para refinar tomas, garantizando acceso a material de alta calidad que se alinee con la narrativa de la marca y los requisitos del cliente. Los equipos que se especializan en la catalogación optimizada pueden implementar flujos de trabajo de optimización sin sacrificar la coherencia narrativa.

Ediciones de ensamblaje asistidas por IA: cuándo aceptar borradores generados por máquinas

Comience con una política concreta: acepte ai-assisted cortes burdos para el montaje inicial de secuencias no críticas, utilizando un prefabricado línea de base que los equipos pueden utilizar como referencia. Asignar un pequeño conjunto de directores, técnicos y animadores para validar la primera pasada y señalar las escenas que necesitan intervención humana.

Defina un umbral de aceptación claro: precisión de objetos colocación, tiempo de imágenes, y suave transicionando entre tomas. Utilizar algoritmos y métodos que se alinean con idea de ritmo y estado de ánimo, y validar continuamente los resultados frente a una referencia. Documentar conocimiento para que los equipos puedan definir expectativas y reutilizar un enfoque consistente.

Criterios de escalación: cuando ai-assisted la salida se desvía de las señales o el ritmo de la marca, o si partidos no están de acuerdo en el estado de ánimo, ingresar una revisión manual por parte de directores y animadores para refinar. Si la retroalimentación muestra una desviación, ellos debería ajustar ya sea los parámetros o cambiar a prefabricado alternativa.

Plan de lanzamiento: mantener un margen cómodo entre los cortes ásperos y las ediciones finales; elige para implementar prefabricado líneas de base en multiple proyectos; mantener un cohesivo conjunto de opciones para selección, permitiendo más rápido comparación y alineación más rápida.

Consejos para la adopción: comience con un pequeño lote de escenas; alinee con el estilo de la imagen; abrace smart ai-assisted processes; train teams on conocimiento of how to define success; keep phones nearby for quick notes and feedback; positive atmosphere.

Conclusion: ai-assisted serves as a tool to help crews, not a replacement for human oversight; by design, this approach accelerates selección and assembly while remaining cohesivo and comfortable for teams; collaboration among directors, animators, and technicians remains essential.

Adaptive color grading tools: integrating AI-match into technical grading pipelines

Adopt AI-match as a dedicated plug-in, a mount between formats and engine, delivering real-time look suggestions while preserving clips.

Main objective: reducing manual trial and error by letting algorithm-driven grades align to reference looks, using facts gathered from prior projects and delivered results across formats.

Diverse inputs from drones and handheld cameras feed into an adaptive engine, with zoom adjustable previews and color lines analyzed across clips, ensuring emotional continuity from scene to scene.

Engine-side integration creates a quick, modular path to modify looks, supports interactive parameter sweeps, and returns previews for client reviews in real time, typically with latency under 150 ms on standard rigs.

Advances in AI supports developers by developing models that learn from tens of thousands of clips (50k+), improving matches and delivering consistent looks across sequences; this reduces adjustments on many jobs.

For clients and teams, processes become more interactive, with quick toggles to modify looks, set references, and compare frames side-by-side; youre able to audit results themselves before final delivery.

Formats range from 8K masters to proxy clips, with delivered looks aligned to briefs; drones, sports, and cinematic footage all benefit from adaptive grading that preserves lines and tonal balance while reducing rework.

Facts-based confidence scores guide when to apply AI-match suggestions, ensuring color integrity and minimizing over-smoothing across genres, with typical scores ranging from 0.7 to 0.95 for sports and documentary projects.

Developers provide controls for quick adjustments, zoom-level previews, and a mount-enabled integration that aligns with existing pipelines, enabling real-time collaboration with clients.

Always-on evaluation practices let filmmakers review results themselves, while AI advances drive faster turnarounds, shifting focus from menial tasks to creative decisions across jobs.

Speech-to-text, subtitles and localization: setting accuracy thresholds and QC steps

Recommendation: Set clear accuracy targets for ASR-driven captions and subtitles, plus a QC ladder. Studio audio: WER ≤ 6%, punctuation 95–98%, timing drift ≤ 0.25 s per cue; field shoots: WER ≤ 8%, punctuation 90–95%, drift ≤ 0.30 s. Use an ASR algorithm, log quick corrections, and adjust thresholds with data from campaigns. This thing helps sustain high-quality outputs across diverse shoots, addressing whether content touches politics or general messaging, and supports long-term reach.

QC layers combine automation, human review, and localization validation. Automated checks parse confidence scores, cue lengths, and punctuation consistency; robotic QC steps handle repetitive checks, freeing specialists to focus on nuance and core functions; human review flags misinterpreted emotions, incorrect speaker labels, and mis-syncs; localization validation tests glossary coverage, cultural references, and back-translation fidelity. Schedule per-file verification plus batch reviews for campaigns with multiple languages.

Operational tips for integration: align captions to rule of thirds for readability on small screens, keep line breaks short, and tune duration per cue to avoid crowding. Maintain a living glossary linking slang, brand terms, and product names to consistent transcripts; adjust curves of timing for speech pace in voiceovers and in interviews to minimize overlaps. Use automation to flag edge cases, but rely on specialists and people on set to approve content before publication.

Data governance and long-term improvement: log every metric, track drift across campaigns, and feed insights into downstream localization pipelines. Ensure audiences on smartphones or desktops receive seamless experiences; measure reach and engagement changes after caption updates. Emotions and tone should map to visuals so that viewers perceive authenticity, not robotic narration. Directors, producers, linguists, and people on set should collaborate to address miscommunications early.

| Aspecto | Target metric | QC step | Frequency | Dueño |

|---|---|---|---|---|

| ASR accuracy | WER ≤ 6% (studio); ≤ 8% (field) | Automated checks; confidence scoring; cross-check with ground truth | Per file | Especialistas |

| Subtitle timing | Drift ≤ 0.25 s per cue | Time alignment pass; manual adjustment if needed | Per chunk | QC lead |

| Localization quality | Glossary coverage > 85%; back-translation fidelity | Glossary verification; back-translation checks | Per campaign | Localization team |

| Emotion and punctuation | Punctuation accuracy 95–98%; emotion cues aligned with visuals | Human review focusing on emotion alignment; punctuation tagging | Per batch | Directors, linguists |

| Consistency across languages | Line breaks and phrasing consistent | Cross-language QA; tests on social captions | Weekly | Engineers |

Asset tagging and search: designing metadata schemas for AI-organized media

Adopt a tiered metadata schema anchored in core fields and a flexible tagging taxonomy to optimize AI-driven organization and search accuracy. Structure comprises three layers: structural metadata (asset_id, project), descriptive metadata (title, description, compositions), and administrative metadata (rights, provenance, version). Define a practical term set mapping across different contexts. This approach becomes indispensable for teams doing rapid retrieval and maintaining consistency across a library of assets. This approach makes it possible to align teams quickly.

Core fields should include asset_id, filename, project, scene, compositions, shot_number, timecode, location, color_space, resolution, frame_rate, camera_model, lens, exposure, audio_id, licensing, access_rights.

Tag taxonomy must be balanced, with broad categories (subject, mood, genre) and granular terms (object, person, action, technique). Maintain consistency with naming conventions; ensure exist consistency across categories and avoid drift. A well-structured hierarchy supports fast filtering and cross-linking between assets; relationships between tags help linking scenes and sequences.

AI-assisted tagging workflow: initial passes by models trained on domain data; human review to correct mis-tagging; adjustments become part of continual learning. Use embeddings to connect descriptions, compositions, and visual cues; enable search by concept, style, or mood; possible to combine textual cues with visual fingerprints for cross-referencing.

Search interface design: support boolean and natural-language queries; enable filters by date, location, subject, composition; include autocomplete and tag suggestions; track usage metrics to optimize schema; watch for bias and gaps; technology becomes a partner in discovery.

Governance and cross-team collaboration: establish ownership, metadata stewardship policy; assign leading data stewards; create naming conventions; exist as a consistent practice across teams; provide training; helping editors and producers align on positioning and expectations; relationships across groups strengthen tagging discipline. If youre integrating metadata across workflows, start with a pilot in a single department.

Optimization and future-proofing: design schemas to accommodate new media types; enable extensions; adopt versioning; support cross-platform interoperability; aim to remove obsolete tags; ensure long-term track record of accuracy; watch for shaky performance in lean pipelines; schedule adjustments as needed; make adjustments possible for future formats.

Outcomes and focus: faster retrieval for different kinds of assets; easier access to compositions; improved reuse across projects; metadata-driven workflows enable originality in edits and storytelling; resulting relationships between teams become more productive and coherent; made possible by disciplined tagging and search.

Quality control of AI fixes (stabilization, upscaling, de-noise): spotting typical failure modes

Begin with an experiment-driven QA plan. Run an automated pilot across a representative set of footage to reveal failure modes under stabilization, upscaling, and de-noise stages. Generate concise forms for technicians to document observations, flags, and proposed fixes. This underpins a structured workflow that keeps businesses competitive by shortening feedback loops and empowering professionals to act quickly.

- Temporal instability: flicker, frame-to-frame jitter, or inconsistent motion after stabilization that breaks continuity in sequences.

- Edge and halo artifacts: halos around high-contrast edges, ringing, or artificial borders introduced by sharpening or upscaling.

- Texture erosion: loss of fine structure in skin, fabric, or artwork; identity may drift when facial detail vanishes or shifts subtly.

- Over-denoising: plasticky skin, smeared textures, or smoothed micro-details that reduce perceived depth and realism.

- Upscaling defects: texture smearing, checkerboard patterns, or color bleeding in enlarged regions where original resolution is insufficient.

- Color and WB drift: inconsistent color balance across shots or within a single scene, altering mood and continuity.

- Temporal color inconsistency: color shifts from frame to frame that disrupt the viewing rhythm, especially in long takes.

- Face and body identity issues: misalignment of landmarks, unnatural eye or mouth movement, or altered proportions during upscaling or stabilization.

- Background foreground separation failures: edge bleed between subject and background, causing ghosting or soft boundaries.

- Motion interpolation errors: smeared motion, ghost frames, or accelerated motion that feels artificial or uncanny.

- Texture misrepresentation in low light: amplified noise patterns or faux grain that clashes with overall grade and lighting.

- Logo and graphic artifacts: aliasing or misplacement near overlays, titles, or lower thirds after processing.

- Temporal inconsistency in noise patterns: mismatch of noise texture across sequence transitions, reducing continuity.

Detection approaches to pinpoint failures nightly include: automated diffs against reference, SSIM and perceptual metrics, and frame-level anomaly scores. Use per-shot identity checks to ensure facial landmarks and body proportions stay stable across fixes, and deploy difference maps to visually localize artifacts. Maintain a log under forms with timestamp, shot ID, and a verdict to enable quick comparisons between previous and current versions.

- Establish acceptance criteria for each form of fix (stabilization, upscaling, de-noise) focusing on continuity, texture integrity, and color fidelity.

- Assign roles to technicians and operators for review rounds; rotate reviewers to avoid bias and broaden culture of feedback.

- Run repeatable experiments with diverse material, including music videos, documentary footage, and artwork-inspired scenes, to expose edge cases.

- Keep cases organized by failure type; generate a knowledge base that teams can consult before subsequent deployments.

- Develop a quick-difference protocol: if a frame deviates beyond a pre-set threshold, route it to manual QA rather than automatic pass/fail.

Remediation and process improvements focus on faster, safer iteration. Create a standardized pipeline where automated passes flag suspect frames, followed by targeted manual checks. This approach helps differentiate quick wins from cautious refinements, preserving identity and artistic intent while maintaining safety for productions. Include examples from filmmaker projects and artwork preservation scenarios to illustrate how fixes impact culture, identity, and overall perception of the work.

Practical recommendations for continuous improvement:

- Embed experiment-driven cycles into daily routines; document outcomes in a cases library for reference.

- Hold regular reviews with a cross-section of professionals, including women, to ensure balanced perspectives and robust quality.

- Keep backups, versioned reels, and traceable logs to protect safety and provenance of artwork.

- Invest in structured training for technicians and operator staff to sharpen diagnostic and correction skills.

- Align fixes with a clear identity-preserving goal while exploring possibilities offered by automated tools.

El Impacto de la IA en los Editores de Videografía – Roles, Habilidades y Flujos de Trabajo Cambiantes" >

El Impacto de la IA en los Editores de Videografía – Roles, Habilidades y Flujos de Trabajo Cambiantes" >