Empfehlungintegrieren Sie KI-beschleunigte Tools, um repetitive Aufgaben zu automatisieren und es Fachleuten zu ermöglichen, einen Großteil ihrer Zeit für visuelles Storytelling aufzuwenden, das bei Zielgruppen Anklang findet. definitiv geeignet für Teams, die traditionell auf manuelle Nachbearbeitung angewiesen waren, während der Fokus auf wesentlicher Qualität erhalten bleibt und enge Fristen eingehalten werden.

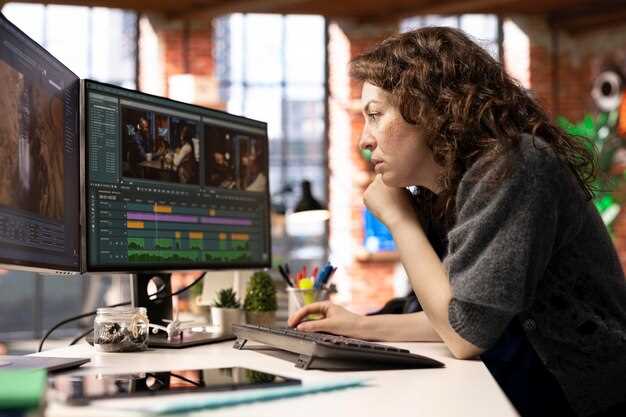

KI verändert Aufgaben im Postproduktion, indem routinemäßige Farbkorrektur, Asset-Tagging und erste Schnittentscheidungen in automatisierte Schleifen verlagert werden. Dieser Artikel beleuchtet, wie man während Pilotprojekten transparente Prüfspuren und Human-in-the-Loop-Checks aufbaut, um trotz Einschränkungen die Sensibilität für Ton und Nuancen zu gewährleisten; dies minimiert die Abweichung über Szenen hinweg. Regelmäßig meetings mit Kunden und Stakeholdern helfen navigieren Erwartungen und verkürzen Sie die Zeit von der Ausbriefung bis zur Auslieferung.

Für Fachleute, die ihr Wissen erweitern möchten, vier praktische Schritte: (1) Erstellen Sie eine Bibliothek von KI-gestützten Voreinstellungen für Farbe, Stabilisierung, Untertitelgenerierung und Animation; (2) die Kompetenzentwicklung um herum ausrichten Animation und Sounddesign zur Unterstützung automatisierter Schnitte; (3) definieren essenziell metriken zur Beurteilung der Ausgabequalität über die Geschwindigkeit hinaus; (4) ausführen meetings mit Klienten, um Erwartungen abzustimmen. Dieser Ansatz traditionell fits business Bedürfnisse erfüllen und gleichzeitig die kreative Absicht bewahren.

In diesem Artikel zeigen frühe Piloten Gewinne: riesig Reduktionen der Zeit bis zum ersten Schnitt und erhöhte Konsistenz bei Metadaten. In der Praxis können KI-gestützte Tagging- und Rough-Grade-Vorschläge iterative Durchgänge um viel und verbessere die Zusammenarbeit mit Publikum. Das Sensibilität to narrative arc ist vital; Menschen sollten kritische Frames überprüfen, insbesondere in Konfligterszenen. Bei der Planung sollte ein Pilotprojekt an einem repräsentativen Projekt durchgeführt werden, um den Einfluss zu messen und zu iterieren.

Überlegungen zur Einführung umfassen das Risiko einer kreativen Abweichung, Datenverwaltung, Lizenzierung generierter Assets und die Abstimmung mit den Zeitplänen der Mandanten. Legen Sie eine klare Verantwortlichkeit für KI-Ausgaben fest und setzen Sie Richtlinien für Farbe, Tempo und Sounddesign. In der Praxis, gestalten Sie es schlank. produktion pipeline und meetings mit Stakeholdern, um Fortschritte zu kalibrieren; dieser Ansatz hilft Teams navigieren Erwartungen erfüllen und einen Mehrwert für Kunden schaffen, während gleichzeitig die Reichweite bei Zielgruppen erweitert wird.

Konkrete Veränderungen in den Verantwortlichkeiten und täglichen Aufgaben der Redakteure

Etablieren Sie einen modularen Bearbeitungsprozess, der auf Bewegungsvoreinstellungen und Stock-Assets basiert, um Routinebearbeitungen drastisch zu reduzieren und Projekte so einfach in Richtung Liefermeilensteine zu lenken.

Erstellen Sie eine zentrale Bibliothek, die von den Teams gemeinsam genutzt wird, um tausende Clips mit minimalem Aufwand zu kuratieren, während Videografen Material vor Ort liefern.

Zerlegen Sie traditionelle Zeitleisten, indem Sie Erstellungselemente dynamisch kombinieren, sodass Farboptionen und Bewegungssequenzen innerhalb von Sekunden neu zusammengesetzt werden können.

Adressen Sie die Verschiebung der Verantwortung, indem Sie Schritte definieren, die die Zusammenarbeit mit Marketern erfordern, um sicherzustellen, dass Lagerbestände und erstellte Assets die Kampagnenziele erfüllen.

Verworfenen, repetitiven Schnittentscheidungen weichen datenbasierte Auswahlen; eine Liste von Hinweisen aus Analysen führt dieses Team zu schnelleren, konsistenteren Ergebnissen.

Präsentationen von Projekten verdeutlichen, wie Tausende von Interessengruppen Bewegung, Farben und Rhythmus wahrnehmen; das Wissen um die Gefühlslage des Publikums formt einen Tanz zwischen Schnitten, wodurch Videografen und Vermarkter eine gemeinsame Vision erreichen können.

revolution advances disrupt traditional processes, requiring disciplined curation and listening to collaborator feedback; this reality pushes thousands of creators to adapt.

Automatisierte Protokollierung und Clip-Auswahl: Konfigurieren von Voreinstellungen und Überprüfen von KI-Auswahlmöglichkeiten

Konfigurieren Sie Voreinstellungen, um automatisch wesentliche Metadaten für jeden Clip zu protokollieren, einschließlich Kamerawinkel, Standort, Takes und Dauer; weisen Sie KI-Auswahlen eine Vertrauenswürdigkeitsscore zu und führen Sie einen Testlauf durch, um die Genauigkeit zu kalibrieren.

In vorhersehbaren Arbeitsabläufen reduziert dieser Ansatz die manuelle Kennzeichnung und beschleunigt die Überprüfung und liefert erstklassige Auswahlen, die mit den narrativen Zielen übereinstimmen.

- Voreinstellungen nach Konzept: kategorisieren Sie Aufnahmen als Szene, Interview, Action, Grafik oder B-Roll; erfassen Sie Felder wie Objektiv, Framerate, Belichtung, Weißabgleich und Farbraum.

- KI wählt die Bewertung aus: Fügen Sie einen Konfidenzwert und einen Grundhinweis hinzu (z. B. „starke narrative Entwicklung“ oder „visueller Schwerpunkt“), damit Gutachter auf einen Blick beurteilen können.

- Bibliothekszugriff: Übereinstimmende Clips in einer zentralen Bibliothek speichern; in Kombination mit der Sora-Integration können Analysten ähnliche Aufnahmen und Trends vergleichen.

Best Practice beinhaltet die Verfeinerung von Voreinstellungen nach einer Testphase. KI-gestützte Überprüfungen zeigen Kosteneinsparungen und Zeitreduktion, während sie Spezialisten unterstützen.

Die Anpassung eines voreingestellten Satzes ist unkompliziert: Passen Sie Kategorien an, ändern Sie Tagging-Felder und führen Sie eine kleine Stichprobe erneut aus; die Ergebnisse geben Hinweise zur Anzahl der Aufnahmen und zur Abstimmung mit Skript oder Storyboard.

Bei der Überprüfung von KI-Auswahlen sollten Sie sich auf eine kompakte Erzählung konzentrieren: Behalten Sie Aufnahmen bei, die zur Entwicklung beitragen, schneiden Sie redundante Takes und bewahren Sie Übergänge; verwenden Sie grafische Overlays, um Auswahlen zu markieren, und exportieren Sie eine Shortlist für Farbentscheidungen am Set oder im Haus.

Praktische Workflow-Tipps:

- Aktivieren Sie die automatische Protokollierung für jeden Clip während der Aufnahme, um eine wachsende Datenbank aufzubauen.

- Führen Sie eine KI-gestützte Vorauswahl durch, gefolgt von einer separaten Filterung nach Stimmung, Tempo und Rhythmus.

- Entscheidungen in einem gemeinsamen Notizfeld anmerken, um zukünftige Sitzungen und die Zusammenarbeit mit Zugriffsteams zu unterstützen.

- Bewerten Sie die Ergebnisse mit einer schnellen Testphase unter Verwendung einer kleinen Spule; messen Sie die Zeitersparnis und den Mehrwert, nicht nur die Menge.

Die Ergebnisse umfassen geringeren manuellen Aufwand, schnellere Vorbereitung und eine Bibliothek, die Trends und die Suche nach bevorstehenden Projekten unterstützt; die Rentabilität verbessert sich, da die eingesparten Gelder in der Nachbearbeitung ansteigen.

Dieser Ansatz demonstriert, wie Spitzenspieler openai-gestütztes Scoring mit avantgardistischer Ästhetik verbinden können; Ton und Rhythmus leiten die Auswahl, während ein angenehmes Gleichgewicht zwischen Vielfalt und Kohärenz erhalten bleibt. Er bietet auch einen klaren Weg für Teams, die Wert und Zugang über verschiedene Abteilungen hinweg optimieren.

Für Teams, die sich auf prägnantes, datengesteuertes Storytelling spezialisieren, bietet die Kombination von Voreinstellungen mit KI-Auswahlen einen skalierbaren Weg, um Aufnahmen zu verfeinern und Zugang zu hochwertigem Material zu gewährleisten, das mit der Markenbotschaft und den Kundenanforderungen übereinstimmt. Teams, die sich auf optimierte Katalogisierung spezialisieren, können schlanke Arbeitsabläufe implementieren, ohne die narrative Kohärenz zu beeinträchtigen.

KI-gestützte Zusammenstellungsbearbeitungen: wann man maschinell erstellte Rohschnitte akzeptieren sollte

Beginnen Sie mit einer konkreten Richtlinie: akzeptieren ai-assisted grobe Schnitte für die anfängliche Montage von nicht-kritischen Sequenzen, unter Verwendung eines fertiggestellt eine Basislinie, mit der Teams vergleichen können. Weisen Sie eine kleine Gruppe von Direktoren, Technikern und Animatoren zu, um den ersten Durchlauf zu validieren und Szenen zu markieren, die menschliche Eingaben erfordern.

Definieren Sie einen klaren Akzeptanzschwellenwert: Genauigkeit von objekte Platzierung, Timing von imagery, und glatt transitioning zwischen den Aufnahmen. Verwenden Sie Algorithmen und methoden that align with idee von Schritt und Stimmung, und kontinuierlich Ergebnisse anhand einer Referenz validieren. Dokumentieren Wissen so Teams Erwartungen definieren und einen konsistenten Ansatz wiederverwenden können.

Eskalationskriterien: wann ai-assisted die Ausgabe von Markenhinweisen oder dem Tempo abweicht, oder wenn Parteien stimmen hinsichtlich der Stimmung nicht überein. enter ein manueller Durchgang von Regisseuren und Animatoren zur Verfeinerung. Wenn Feedback Abweichungen zeigt, sie sollte entweder Parameter anpassen oder zu fertiggestellt alternative

Rollout plan: einen komfortablen Abstand zwischen Rohschnitten und Endbearbeitungen wahren; choose Bereitstellen fertiggestellt baselines in multiple projects; keep a kohäsiv Satz von Optionen für Auswahl, die Ermöglichung von schneller Vergleich und schnellere Ausrichtung.

Tipps für die Adoption: Beginnen Sie mit einer kleinen Anzahl von Szenen; stimmen Sie mit dem Bildstil überein; umarmen Sie smart ai-assisted Prozesse; Teams in Wissen von wie definieren Erfolg; behalten phones in der Nähe für schnelle Notizen und Feedback; positiv Atmosphäre.

Fazit: ai-assisted dient als Werkzeug, um Besatzungen zu unterstützen und nicht als Ersatz für menschliche Aufsicht; dieses Vorgehen ist von Natur aus darauf ausgelegt, zu beschleunigen Auswahl und Montage, während sie verbleiben kohäsiv und komfortabel für Teams; die Zusammenarbeit zwischen Direktoren, Animatoren und Technikern bleibt unerlässlich.

Adaptive Farbkorrektur-Tools: Integration von AI-Match in technische Grading-Pipelines

Nutzen Sie AI-match als ein dediziertes Plug-in, eine Verbindung zwischen Formaten und Engine, das in Echtzeit Look-Vorschläge liefert und dabei Clips beibehält.

Hauptziel: Reduzierung von manuellem Versuch und Irrtum, indem algorithmusgesteuerte Noten an Referenzlooks angepasst werden, unter Verwendung von Fakten, die aus früheren Projekten und den gelieferten Ergebnissen in verschiedenen Formaten gewonnen wurden.

Verschiedene Eingaben von Drohnen und Handkameras werden in eine adaptive Engine eingespeist, mit zoomverstellbaren Vorschauen und Farbprofilen, die über Clips hinweg analysiert werden, um eine emotionale Kontinuität von Szene zu Szene zu gewährleisten.

Die Engine-seitige Integration schafft einen schnellen, modularen Pfad, um Looks zu modifizieren, unterstützt interaktive Parameterscans und liefert Vorschauen für Kundenprüfungen in Echtzeit, typischerweise mit einer Latenz von unter 150 ms auf Standard-Rigs.

Fortschritte in der KI unterstützen Entwickler, indem sie Modelle entwickeln, die aus zehntausenden Clips (50.000+) lernen, Übereinstimmungen verbessern und konsistente Looks über Sequenzen hinweg liefern; dies reduziert Anpassungen bei vielen Jobs.

Für Kunden und Teams werden Prozesse interaktiver, mit schnellen Umschaltern, um Looks zu modifizieren, Referenzen festzulegen und Frames nebeneinander zu vergleichen; Sie können die Ergebnisse selbst vor der endgültigen Lieferung prüfen.

Formate reichen von 8K-Mastern bis hin zu Proxy-Clips, wobei die gelieferten Looks auf die Briefings abgestimmt sind; Drohnen-, Sport- und Kinofilmmaterial profitieren alle von adaptivem Grading, das Linien und Tonales bewahrt und den Neuaufwand reduziert.

Faktenbasierte Konfidenzwerte steuern, wann KI-Matching-Vorschläge angewendet werden, um die Farbintegrität zu gewährleisten und eine übermäßige Glättung über Genres hinweg zu minimieren, wobei typische Werte für Sport- und Dokumentarprojekte zwischen 0,7 und 0,95 liegen.

Entwickler stellen Bedienelemente für schnelle Anpassungen, Vorschauen mit Zoom-Level und eine montagefähige Integration bereit, die mit bestehenden Pipelines übereinstimmt und die Echtzeit-Zusammenarbeit mit Kunden ermöglicht.

Always-on-Evaluierungspraktiken ermöglichen es Filmemachern, Ergebnisse selbst zu überprüfen, während Fortschritte in der KI schnellere Bearbeitungszeiten ermöglichen und den Fokus von eintönigen Aufgaben auf kreative Entscheidungen in allen Bereichen verlagern.

Sprache-zu-Text, Untertitel und Lokalisierung: Festlegung von Genauigkeitsschwellenwerten und Qualitätskontrollschritten

Empfehlung: Legen Sie klare Genauigkeitsziele für ASR-gesteuerte Untertitel und Bildunterschriften fest, zusätzlich zu einer Qualitätskontrollhierarchie. Studioaudio: WER ≤ 6%, Interpunktion 95–98%, Timing-Drift ≤ 0,25 s pro Cue; Dreharbeiten vor Ort: WER ≤ 8%, Interpunktion 90–95%, Drift ≤ 0,30 s. Verwenden Sie einen ASR-Algorithmus, protokollieren Sie schnelle Korrekturen und passen Sie die Schwellenwerte mit Daten aus Kampagnen an. Dies hilft, hochwertige Ausgaben über vielfältige Drehs hinweg aufrechtzuerhalten, unabhängig davon, ob der Inhalt politische Themen oder allgemeine Botschaften behandelt, und unterstützt die langfristige Reichweite.

QC-Schichten kombinieren Automatisierung, menschliche Überprüfung und Lokalisierungsvalidierung. Automatisierte Prüfungen parsen Konfidenzwerte, Cues zur Länge und Zeichenrechtschreibung; Roboter-QC-Schritte erledigen sich wiederholende Prüfungen, wodurch Spezialisten sich auf Nuancen und Kernfunktionen konzentrieren können; Menschliche Überprüfungen markieren fehlinterpretierte Emotionen, falsche Sprecherbezeichnungen und Fehlanpassungen; Lokalisierungsvalidierung testet die Glossarabdeckung, kulturelle Referenzen und die Rückübersetzungstreue. Planen Sie eine Dateiverifizierung sowie Batch-Überprüfungen für Kampagnen mit mehreren Sprachen.

Betriebstipps für die Integration: Richten Sie Untertitel an der Drittel-Regel aus, um die Lesbarkeit auf kleinen Bildschirmen zu gewährleisten, halten Sie Zeilenumbrüche kurz und stimmen Sie die Dauer pro Hinweis ab, um ein Überfüllen zu vermeiden. Pflegen Sie einen lebenden Glossar, der Slang, Markenbegriffe und Produktnamen mit konsistenten Transkripten verknüpft; passen Sie die Kurven der Zeitgebung für die Sprechgeschwindigkeit in Voiceovers und in Interviews an, um Überlappungen zu minimieren. Verwenden Sie Automatisierung, um Sonderfälle zu kennzeichnen, verlassen Sie sich aber auf Spezialisten und Personen am Set, um Inhalte vor der Veröffentlichung zu genehmigen.

Datengovernance und langfristige Verbesserung: Protokollieren Sie jede Metrik, verfolgen Sie Abweichungen über Kampagnen hinweg und speisen Sie Erkenntnisse in nachgelagerte Lokalisierungspipelines ein. Stellen Sie sicher, dass Zielgruppen auf Smartphones oder Desktops nahtlose Erlebnisse erhalten; messen Sie Reichweiten- und Engagementänderungen nach Untertitelaktualisierungen. Emotionen und Ton sollten auf visuelle Elemente abgestimmt sein, damit Zuschauer Authentizität wahrnehmen, nicht robotische Erzählungen. Regisseure, Produzenten, Linguisten und Personen am Set sollten zusammenarbeiten, um Missverständnisse frühzeitig zu beheben.

| Aspekt | Zielmetrik | QC Schritt | Frequenz | Eigentümer |

|---|---|---|---|---|

| ASR-Genauigkeit | WER ≤ 6% (Studio); ≤ 8% (Feld) | Automatisierte Prüfungen; Konfidenzbewertung; Kreuzvalidierung mit Ground Truth | Pro Datei | Spezialisten |

| Untertitel-Timing | Drift ≤ 0.25 s pro Hinweis | Zeitabstimmungsvorgang; bei Bedarf manuelle Anpassung | Per Chunk | QC lead |

| Lokalisierungsqualität | Glossar-Abdeckung > 85%; Rückübersetzungsgetreue | Glossarverifizierung; Rückübersetzungskontrollen | Pro Kampagne | Lokalisierungsteam |

| Emotion und Interpunktion | Punctuation accuracy 95–98%; emotion cues aligned with visuals | Menschliche Überprüfung mit Fokus auf Emotionsübereinstimmung; Interpunktionskennzeichnung | Pro Charge | Direktoren, Linguisten |

| Konsistenz über Sprachen hinweg | Zeilenumbrüche und Formulierungen konsistent | Cross-Language QA; Tests auf Social-Media-Bildunterschriften | Wöchentlich | Ingenieure |

Asset-Tagging und -suche: Entwicklung von Metadataschemata für KI-organisierte Medien

Verwenden Sie ein abgestuftes Metadaten-Schema, das auf Kernfeldern und einer flexiblen Tagging-Taxonomie basiert, um die KI-gesteuerte Organisation und Suchgenauigkeit zu optimieren. Die Struktur umfasst drei Ebenen: strukturelle Metadaten (asset_id, Projekt), beschreibende Metadaten (Titel, Beschreibung, Kompositionen) und administrative Metadaten (Rechte, Provenienz, Version). Definieren Sie eine praktische Begriffsmengenzuordnung über verschiedene Kontexte hinweg. Dieser Ansatz wird unerlässlich für Teams, die eine schnelle Wiederherstellung durchführen und die Konsistenz über eine Bibliothek von Assets hinweg aufrechterhalten. Dieser Ansatz ermöglicht es Teams, sich schnell abzustimmen.

Kernfelder sollten asset_id, filename, project, scene, compositions, shot_number, timecode, location, color_space, resolution, frame_rate, camera_model, lens, exposure, audio_id, licensing, access_rights umfassen.

Tag-Taxonomien müssen ausbalanciert sein, mit breiten Kategorien (Thema, Stimmung, Genre) und detaillierten Begriffen (Objekt, Person, Aktion, Technik). Achten Sie auf Konsistenz mit Namenskonventionen; stellen Sie Konsistenz über Kategorien hinweg sicher und vermeiden Sie Abweichungen. Eine gut strukturierte Hierarchie unterstützt schnelles Filtern und die Verknüpfung zwischen Assets; Beziehungen zwischen Tags helfen beim Verknüpfen von Szenen und Sequenzen.

KI-gestützte Tagging-Workflow: anfängliche Durchgänge durch Modelle, die auf Fachdaten trainiert wurden; menschliche Überprüfung zur Korrektur von Fehlmarkierungen; Anpassungen werden Teil des kontinuierlichen Lernens. Verwenden Sie Einbettungen, um Beschreibungen, Kompositionen und visuelle Hinweise zu verbinden; ermöglichen Sie die Suche nach Konzepten, Stil oder Stimmung; möglich, Textmerkmale mit visuellen Fingerabdrücken für Querverweise zu kombinieren.

Suchoberflächendesign: Unterstützung von booleschen und natürlichsprachlichen Abfragen; Ermöglichung von Filtern nach Datum, Ort, Thema, Zusammensetzung; Einbeziehung von Autovervollständigung und Tag-Vorschlägen; Verfolgung von Nutzungsmetriken zur Optimierung des Schemas; Beobachtung auf Verzerrungen und Lücken; Technologie wird zu einem Partner bei der Entdeckung.

Governance und cross-team Zusammenarbeit: Verantwortlichkeit festlegen, Richtlinie für die Betreuung von Metadaten erstellen; führende Datenbetreuer benennen; Namenskonventionen erstellen; als eine konsistente Praxis über Teams hinweg existieren; Schulungen anbieten; Redakteuren und Produzenten helfen, sich auf Positionierung und Erwartungen abzustimmen; Beziehungen zwischen Gruppen stärken die Disziplin beim Tagging. Wenn Sie Metadaten in Workflows integrieren, beginnen Sie mit einem Pilotprojekt in einer einzelnen Abteilung.

Optimierung und Zukunftsfestigkeit: Entwerfen Sie Schemata, um neue Medientypen aufzunehmen; aktivieren Sie Erweiterungen; übernehmen Sie Versionierung; unterstützen Sie die plattformübergreifende Interoperabilität; bemühen Sie sich, veraltete Tags zu entfernen; stellen Sie einen langfristigen Nachweis der Genauigkeit sicher; achten Sie auf eine schwankende Leistung in schlanken Pipelines; planen Sie Anpassungen nach Bedarf; machen Sie Anpassungen für zukünftige Formate möglich.

Ergebnisse und Fokus: schnellere Abrufe für verschiedene Arten von Assets; einfacherer Zugriff auf Kompositionen; verbesserte Wiederverwendbarkeit über Projekte hinweg; metadatenbasierte Workflows ermöglichen Originalität bei Bearbeitungen und Storytelling; daraus resultierende Beziehungen zwischen Teams werden produktiver und kohärenter; ermöglicht durch disziplinierte Verschlagwortung und Suche.

Qualitätskontrolle von KI-Fixes (Stabilisierung, Hochskalierung, Entrauschen): Erkennen typischer Fehlerarten

Beginnen Sie mit einem experimentgesteuerten QA-Plan. Führen Sie einen automatisierten Pilotlauf über einen repräsentativen Satz von Aufnahmen durch, um Ausfallmodi in den Phasen der Stabilisierung, Hochskalierung und Entrauschung aufzudecken. Erstellen Sie prägnante Formulare für Techniker, um Beobachtungen, Markierungen und vorgeschlagene Korrekturen zu dokumentieren. Dies bildet die Grundlage für einen strukturierten Workflow, der Unternehmen wettbewerbsfähig hält, indem er Feedback-Schleifen verkürzt und Fachleute befähigt, schnell zu handeln.

- Zeitliche Instabilität: Flimmern, Frame-to-Frame-Ruckeln oder inkonsistente Bewegung nach Stabilisierung, die die Kontinuität in Sequenzen unterbricht.

- Kanten- und Halos: Helme um hochkontrastreiche Kanten, Ringer oder künstliche Ränder, die durch Schärfen oder Hochskalieren entstehen.

- Textur Erosion: Verlust feiner Strukturen in Haut, Stoff oder Kunstwerk; Identität kann sich verschieben, wenn Gesichtszüge verschwinden oder sich subtil verändern.

- Over-Denoising: Plastisch wirkende Haut, verschmierte Texturen oder geglättete Mikrodetails, die die wahrgenommene Tiefe und den Realismus reduzieren.

- Upscaling-Defekte: Texturverschmieren, Schachbrettmuster oder Farbabflösung in vergrößerten Bereichen, wo die ursprüngliche Auflösung unzureichend ist.

- Farb- und WB-Drift: Inkonsistente Farbausgewogenheit über Aufnahmen oder innerhalb einer einzelnen Szene, die Stimmung und Kontinuität verändert.

- Temporale Farbinkonsistenz: Farbschwankungen von Frame zu Frame, die den Sehrythmus stören, insbesondere in langen Einstellungen.

- Gesichts- und Körperidentitätsprobleme: Fehlstellung von Landmarken, unnatürliche Augen- oder Mundbewegungen oder veränderte Proportionen beim Hochskalieren oder Stabilisieren.

- Hintergrund-Vordergrund-Trennungsausfälle: Kantenblutung zwischen Motiv und Hintergrund, die Geisterbilder oder weiche Grenzen verursacht.

- Fehler bei der Bewegungsinterpolation: Verwischte Bewegung, Geisterbilder oder beschleunigte Bewegung, die sich künstlich oder unheimlich anfühlt.

- Fehlinterpretation der Textur bei schwachem Licht: verstärkte Rauschmuster oder falsche Körnung, die nicht mit der Gesamtqualität und Beleuchtung übereinstimmen.

- Logo- und grafische Artefakte: Aliasing oder Fehlplatzierung in der Nähe von Overlays, Titeln oder unteren Dritteln nach der Verarbeitung.

- Zeitliche Inkonsistenz in Rauschmustern: Abweichung der Rauschtextur über Sequenzübergänge, wodurch Kontinuität reduziert wird.

Detection approaches to pinpoint failures nightly include: automatisierte Diffs gegen Referenz, SSIM und Wahrnehmungsmetriken sowie Frame-Level-Anomaliebewertungen. Nutzen Sie Identity-Checks pro Shot, um sicherzustellen, dass Gesichtspunkte und Körperproportionen über Fixes hinweg stabil bleiben, und setzen Sie Differenzkarten ein, um Artefakte visuell zu lokalisieren. Führen Sie ein Protokoll unter Formularen mit Zeitstempel, Shot-ID und einem Urteil, um schnelle Vergleiche zwischen vorherigen und aktuellen Versionen zu ermöglichen.

- Legen Sie Akzeptanzkriterien für jede Form der Fehlerbehebung fest (Stabilisierung, Hochskalierung, Entrauschung) mit Fokus auf Kontinuität, Texturintegrität und Farbgenauigkeit.

- Technikern und Betreibern Rollen für Überprüfungsrunden zuweisen; Gutachter rotieren, um Verzerrungen zu vermeiden und eine Feedback-Kultur zu fördern.

- Führen Sie wiederholbare Experimente mit verschiedenen Materialien durch, darunter Musikvideos, Dokumentaraufnahmen und kunstinspirierte Szenen, um Randfälle aufzudecken.

- Fälle nach Fehlertyp organisieren; eine Wissensdatenbank erstellen, die Teams vor nachfolgenden Bereitstellungen konsultieren können.

- Entwickeln Sie ein Schnell-Differenz-Protokoll: Wenn ein Frame einen vordefinierten Schwellenwert überschreitet, leiten Sie ihn zur manuellen QA weiter, anstatt ihn automatisch zu genehmigen oder abzulehnen.

Remediation und Prozessverbesserungen konzentrieren sich auf schnellere, sicherere Iteration. Erstellen Sie eine standardisierte Pipeline, in der automatisierte Durchläufe verdächtige Frames kennzeichnen, gefolgt von gezielten manuellen Überprüfungen. Dieser Ansatz hilft, schnelle Erfolge von vorsichtigen Verfeinerungen zu unterscheiden und gleichzeitig die Identität und künstlerische Absicht zu bewahren und die Sicherheit für Produktionen zu gewährleisten. Fügen Sie Beispiele aus Filmemacherprojekten und Szenarien zur Kunstwerkserhaltung hinzu, um zu veranschaulichen, wie Korrekturen sich auf Kultur, Identität und die Gesamtperzeption des Werks auswirken.

Praktische Empfehlungen für kontinuierliche Verbesserung:

- Experimentgesteuerte Zyklen in die täglichen Routinen einbetten; Ergebnisse in einer Fallstudienbibliothek zur Referenz dokumentieren.

- Führen Sie regelmäßige Überprüfungen mit einem Querschnitt von Fachleuten durch, einschließlich Frauen, um ausgewogene Perspektiven und robuste Qualität sicherzustellen.

- Sichern Sie Backups, versionierte Reels und nachvollziehbare Protokolle, um die Sicherheit und Provenienz von Kunstwerken zu schützen.

- Investieren Sie in strukturierte Schulungen für Techniker und Bedienerpersonal, um die Diagnose- und Korrekturfähigkeiten zu verbessern.

- Richten Sie Korrekturen mit einem klaren, identitätsschützenden Ziel aus, während Sie die Möglichkeiten automatisierter Tools erkunden.

Der Einfluss von KI auf Videobearbeiter – Veränderte Rollen, F0higkeiten & Arbeitsabläufe" >

Der Einfluss von KI auf Videobearbeiter – Veränderte Rollen, F0higkeiten & Arbeitsabläufe" >